投稿者: Kei

Happy 303 Day :) 2026

昨年に続き今年も303Day用に動画をとりました!

Roland TB-303クローン、Behringer TB-3をメインにしたJAMをしてみました。

シーケンサー)KORG SQ-1

音源) Pocket Operator / Tonic, Sub, Speak

Poket Operatorは同期・音声信号をディジーチェーンで繋いですべてのミックスして出力することができますが、ここでは個別にミキサーに繋いでいいます。同期、音声の2ch出力を分岐して、片方は次のPO,片方はミキサーにモノラルインしています。分けるとパンができて音が広がっていい感じになりました。

ちょっと雑なレイアウトになってしまったのは反省点です。

やはり303サウンドはいつ聴いてもいいですね〜 主役のくってしまうPocket Operatorサウンドもかなり強烈です!

Six VOLCAs Ensamble (2)

前回にひきつづきVOLCAアンサンブルです。

今回チャレンジしたのは、フレーズのリアルタイムレコーディングです。

思った通りのフレーズにならなかったりするとかなり焦りますが、きまるとかなり気持ちいいです。アドリブのようでもありますが、ループしてしまうので、またちがった感覚で組み立てる必要があります。フレーズだけでなくコントールの同様で、イメージした音色にならないと何度もやり直しなおしたりするので、カッコわるい・・

難しかったということをここに記録しておき、また次につなげたいと思います。

Six VOLCAs Ensamble

やっと設備が整い、やってみたかったことができました!(ブームはすでに去ってしまった・・)

3Dプリンタの自作スタンドで並べて、6台でのシンクは初めての体験です。コンパクト音源はバンドのメンバーみたいに考えていますので、それぞれの個性をちょっとずつ活かしたアンサンブルをやってみたいと思っていました。今回は特にプランもなく接続テストのような意味合いです。

台数が増えると操作が難しいのでもっと修行が必要です。

JAMuary 2026

今年もJAMuary と称してJAMってみました。

前回にひきつづき、Pocket Operatorを使用しました。

PO-35 speakは、ボーカルシンセサイザーといわれサンプリングした音声に、さまざまなエフェクトをかけられます。声というのは音源としてこれ以上のものはないと思っています。これがあるだけで一気に有機的になります。ただサンプリングしただけのものだけを使用すると主張が強すぎるので、このくらいのローファイ感あるくらいが扱いやすく感じます。

実は、サンプルネタはSUNOで曲を作ってボーカル分離という方法を試してみました。狙いどおりの声にはなりませんでしたが、これは今後の課題です。

POは、音をかなりいじれるのでどこのボタンに何がアサインされているかをよく知っていないとなかなかクールなプレイができません。まだまだ修行が・・ 作業中断時は記録に残すと次が入りやすいのでとりあえずこの形で。ドラムパートと連動するノートエフェクトはかなり強力です。操作性といい開発者のセンスがいい!

今回、4台のマシンを使っていますが、Syncをデイジーチェーン、オーディオをMIX-IN/OUでつなぐ機能のおかげで、とてもコンパクトです。しかもすべてバッテリー駆動。

Aira Compactは今回積極的にはつかっていませんが、なにかと便利な機材です。

PO,Airaともシリーズ中この2台がお気に入りです。3Dプリンターでラックもつくりました。

Volcaを使ってやりたいことがまだ消化できないうちにAiraとか買ってしまい、やりたいことがたまるばかりですが、ぼちぼち今年もやっていきたいと思っています。

Casual Demo (2)

カジュアルと言えば、前回よりもこの形態の方がよりカジュアルです。すべてバッテリー駆動で動きますし、もっと小型です。

今さら感のある、古いガジェット Pocket Operator 14 Submarine、電池駆動のみですが、音圧がありとても好きです。

今回は、いろんなチャレンジができました。

P-6には、V-Drumsで叩いたドラムをフレーズサンプリングしてからチョップしています。120BPMでサンプリングして133BPMで鳴らしています。等間隔に正確にサンプリングできないのでごまかしたのもありますが、細切れ感がマシンっぽくなります。リアルタイムでピッチも変えられるので、P-6は面白い!

POシリーズは本当によくできていて、ステップシーケンサ好きとしてはもっとサイズが大きいものが欲しいです。楽器を演奏するが如くフレーズを変えることにトライしましたが、思い通りなかなかいきませんでした。

二度と同じ操作はできないだけに、動画にとっておく意味を感じます。気に入ったところはまたチャレンジ!

簡単に撮ることのメリットは大きい・・

Casual Demo

Q2n4kのカメラを購入!iPhoneで動画撮影をしてきましたが、もっと簡単にセッティングできるようになりました。

画質は少し劣りますが音はいいです!

Mix-InがついているRoland P-6と合わせて、カジュアルに動画をとってみました。

P-6からQ2nにはステレオミニで直接繋げます。ちょっと撮ってみたいと思ってすぐ撮れることはとても重要ですね。

音源は長らく時間がなくほっておいたProVsMiniです。面白い機材で好きですが、ベクトル操作に難があるところがちょっと惜しいです。

動画をみていただくとわかりますが、エンベロープ設定画面で操作しています。もう少し修行が必要です。

他の音源も宿題にしていることが多いので、どんどん撮れたらと思っています。

いずれはマシンライブをやってみたい!

Noisevember 2025

VITALというソフトシンセを使って今年もNOISEvember動画を作ってみました!VITALは随分前から知っていましたが、ちょっといじる程度でここまで使うのは初めてです。

いろいろ忙しく3か月振りになってしまいました。AIの研究にかなりの時間がとられている今日このごろです。

今年のAIの進化は、世界に大きな変化をもたらしました。私の価値観もかなり変えられました。しかし音楽を創造することに関しては、今までと変わらない意欲を持ち続けています。AIエージェントによるコーディングが100倍以上の速さでできたり、身体性をともなう楽器の習得の意欲が衰えないことがその要因です。

モジュラーシンセなどのツマミ操作も演奏の範疇と思っています。実はNoisevemberはモジュラーシンセなど物理音源を使ったものなので、ソフトシンセは相応しくないかもと思いました。しかしWaveテーブルを使ったシンセのダイナミズムが好きなので、これを使って何かやりたいと思っていたため、チャレンジしました。(物理音源ならCyDrumsか・・ほしい・・)

ポイントはシーケンサとか使わずLFOでリズムを作ることです。(これ好き)

ツマミ操作にMIDIコントローラを使おうと思いましたが、物理音源を触るときはすべて目に見えることから、すべてマウス操作にしました。Noisevemberとしてこだわったのは、音づくりのソフトシンセを一応リアルタイムで操作したことです。

反省点)エフェクトが強すぎて音がぼやけてしまった。

本当のところは下記の動画のようなものを出したかったです。しかしRoATは操作が難しく、もう使い方を忘れてしまったため、断念しました。(それよりも新しいチャレンジを優先)

この動画、個人的にとても気にいっていて、ときどきノイズの中に身をおきたくなる衝動にかられます。

“Dive Into the Noise!”

やっぱり物理音源はいいなあ・・

BLACK SAMURAI 2025

この度、IGアリーナで開催されてNBA八村塁選手が主催する、BLACK SAMURAI 2025初日に見学する機会を得ました。

このイベントは中学生、高校生が直接NBA仕込みのトレーニングを体験できるもので、これまでなかなか無かったことです。3000人以上の応募の中から150人が選抜されました。大型モニターやマイク、通訳つきなので、スタントで見学する人もその内容が全て公開されています。

https://blacksamurai2025.ruihachimura.com/

中学、高校とバスケットをやった経験から、今でも好きなのですが、地元名古屋でこのようなビッグイベントがあるということで、とても驚いています。塁選手の地元が富山であることや、IGアリーナが本場NBAの会場に近いということもあるのでしょう、この地域のバスケットが盛り上がるといいですね。

プレスインタビューの後始まりましたが、フィル・ハンディ氏がコーチで塁選手を相手にまず見本を見せてから、練習をスタートする形をとっていました。

ここで取り上げたのは、ドラム演奏とバスケットをプレイするときの感覚に類似点があると昔から思っていたからです。ドリブル時のリバウンドの意識や全身の使い方、手足のバランスなど。。今回のワークアウトを見て、改めてその感覚が正しかったことを認識しました。

ウォーミングアップ時のフィルコーチのドリブルが無茶苦茶速い!手だけのドリブルでなく足も含めたコンビネーションのパターンをいくつか見せてくれました。体の動きが自然でバランスが良く、ボールをつく音、キャッツする音、ステップの音が正確に刻まれる様子は、心地よく聴こえました。手首のスナップの強さからくるボールのスピード、ステップのスピード、NBAのレベルを間近で見られたことは、貴重な機会でした。50代前半とのことですが、塁選手曰くなかなか来てもらうことが難しい人、といっているのもわかる気がします。

スポーツも音楽もそうですが、身体性に関わる部分というのは鍛錬という精神性とも深く絡んで探究ができることから、時代がどれだけ進もうとも尊重される対象だと改めて思いました。

Spain

今度のライブで、熱帯JAZZ楽団「Spain」のドラムを叩くことになりました。

そこで、コンテスト動画を撮ったついでに、スペインも撮ってみました。

熱帯の曲は以前もマチューテの動画も撮りましたが、どちらもフレーズを作りこんだことから、記録に残しておく意図があります。なぜ作りこむかというと、熱帯はパーカッショニストが大勢いて音も分厚いのですが、バンドでは少人数のため、その分ドラムで叩こうとするからです。

結局どちらの曲も、ゴーストノートを使った同じようなアプローチをしています。スペインはさまざまなアーティストが演奏する名曲で、昔からやってみたかったため、今回はモチベーションが高いです!

エレドラだとハイハットがあまり弾んでくれないので、そこにどうしても力が入ってしまいました。コンテスト動画の続きでとったので、テンポがいつもより早く感じました。ついではやめた方がよさそうです。

このテンポで片手タッタカは自分の限界スピードかもしれません。(メモ)

ライブで叩くとき、せっかくの機会なので毎回チャレンジポイントを作るようにしてます。今回はジョジョメイヤーのやりかたにならった、バスドラの連打を練習しました。まだ不完全ですが、このテンポならできそうです。

楽しめるネタがあると、練習がはかどります。

おっ、スペインの動画で100本目だ!

16年以上やっているので全然少ないですが、ちょっと感慨ぶかいです。

Find the Pocket

今年も恒例のドラムマガジンコンテストの曲を演奏してみました。

マスターコース課題曲 「Veil of Time」 Composed by 山本真央樹

うーんさすが、この人の曲は難しい。。7/8の変拍子の曲です。

7/8といえば Dave Weckl の Island Magic を練習したことがありました。16分音符14個分を、4 4 3 3 とカウントすると叩きやすいことを思い出し、役にたちました。当時この曲をきいて変拍子をつかっていると思えないほど自然だったことに驚きました。プレイもしかり。デイブのフレーズってきれいなんですよね。

今回のプレイはフレーズに凝るゆとりもなく、合わせるのに精いっぱいでした。

たぶん今までで一番難しかったのではないでしょうか・・あきらめるのも早かった・・

とりあえずチャレンジした記念に動画にしました。

MicroFreak Step Sequencer Demo

3ヶ月ぶりの投稿になりました!

(やりたいことはたくさんあるのですが、今年に入ってからAI関連で今まで考えられなかった技術のジャンプがあったため、そちらの研究に時間を取られています。ほんと最近すごい・・価値観が覆る)

MicroFreakの動画も久しぶりになりますが、前回動画同様M5Stack(今回はCore2)を使ってMIDIデータ加工をして、サウンドを変化させています。

MicroFreakはパラメータの数が多く、音作りの自由度がかなり高いのですが、リアルタイムでつまみを触ろうと思うと、手が足りません。またオシレータの切り替えによる変化がとても面白いので、ステップでパラメータを変えるプログラムを作って、音色変化でパターンを作れるようにしました。

パラメータ変化には、8チャンネルのロータリーエンコーダを使用し、8ステップのループでパターンを作ることができます。

効果的にはWave Sequenceの独特なノリになります。まずその効果をテストをしたかったので、デモ動画を撮りました。

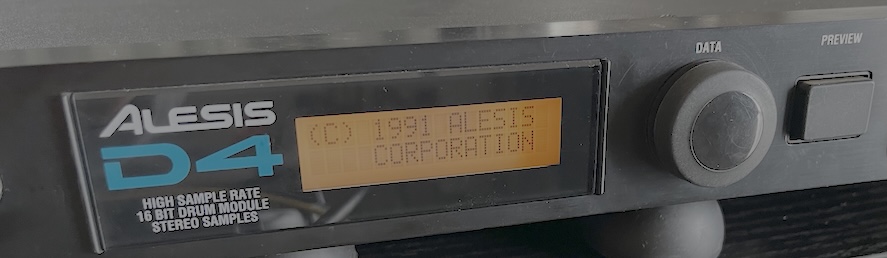

Linear Drumming / Alesis D4

今回は古いドラム音源を使ったテストをしてみました。

仕事などで必要になったものでなく、自分の音楽表現のために欲しいと思ったシンセなどの機材は、いつか必要になると思って、なかなか手放せずにずっと持っている方です。

Alesis D4のドラム音源は、ドラムパッドやピックアップからトリガーもできるため、当時Roland TD-7の拡張音源用に購入しました。

最近Volcaのスタイルでプレイしていると、このタイプの音源は使いずらかったのですが、SQ-1によって同じ土俵で使えるものになりました。リニアドラミングというのは1音1音直線的に並べて叩く奏法で、独特のノリを出すために、実際のドラム演奏でよく使われるものですが、SQ-1の仕様がモノフィックなのと、D4がドラム音源を鍵盤のノートに並べられることから、相性がいいということで、リニアドラミングというタイトルにしました。

2オクターブ分の音をSQ-1のつまみで切り替えますが、低い方からバスドラ、ハイハット&FX、スネアドラムのグループを並べました。

問題はメモリに設定を保持するバッテリが切れているため、保存できないことですが、MIDI System Exclusive Dataの送受信で対応。

また音の変化が物足りなかったので、SQ-1の機能を拡張する目的でM5Stackとその周辺機器を使って、MIDIメッセージを加工するカスタムプログラムを作成。

ドラム音源はサンプラーにするのかどうか、とても迷います。Volca Sample、Volca Drumもいいのですが、もうちょっと音圧が欲しいのと、かといって場所をとるのもちょっと。。Alesisは1Uで下に置けば場所を取らず、操作はSQ-1だけで、しかも音が良いということで最適でした。ピッチベンドで音が変わることもすごく気にいっています。

あと古いラバーのドラムパッドRoland PD-7で鳴らすテストもしました。ステレオ標準プラグで接続しますが、リムの音をトリガーするには、Yケーブルで分岐する必要があります。しかし信号が弱いためGAINを99にしても、音がなったり鳴らなかったり。もちろんRolandのドラム音源ではこの辺り調整されていてYケーブルを使うことなく問題なく使えます。このパッドも古いため断線していましたが、はんだ付けをすることで直りました。

古い機材ですが、もっと古い時代の設計(ステップシーケンサ)を持った新しい製品SQ-1で甦るとは、不思議は気持ちです。

モノは大切に!

M5Stackについて

下記でテストしたときのプログラムがベース

「M5Go Groove」

https://decode.red/ed/archives/1752

ボタン: ノートナンバーを増減。これにより鍵盤にアサインされたドラムの音源が一つずつずれる。(真ん中のボタンで設定情報をSysex 送信)

ダイアル:ピッチベンド。

ジョイスティック:音符を倍、3/2倍。X方向は最新の音をコピー。Y方向は最初の音をコピー。

Happy 303 Day :) 2025

昨年に続き今年も303Dayに参加です!

メインは、TB-303クローンマシンのBehringer TD-3です。

シーケンサはKorg SQ-1、キックはもちろんVolca Kick、ハイハットパートはBehringer Pro VS mini ver2。

エフェクタはKorg NTS-1 のディレイ。

同期はシーケンサSQ-1から、NTS-1 -> Volca Kick -> Pro VS です。

Pro VSとは、Prophet Vector Synthesizer の パク、いや復刻版です。

Prophet という名機のネーミングに、ベクトルシンセという特徴、5音ポリ、Volcaフィール、これらが1万円台ということで、手にとらざるを得ない状況となりました。ベクトルシンセのようなコントローラものは好きで、YAMAHA SY-22、Korg WaveStationも所有していました。Pro VSはアルペジオレータなどのキーオンでVectorシーケンスが設定値からスタートするところが不満ですが、ファームウェアがよくアップデートされているので、改善があれば、と期待しています。(ホールドもなかったが改善された)ですので動画では設定画面で操作してます。

今回復刻を得意とするBehringerのマシンを二つ並べてみました。また Pro VSというのはVolca のデザインも真似ています。ユーザとしては、いいものが安く手に入るのはありがたいですが、著作権関係でグレーのものもありそうです。(LinnDrumなど)Volcaとの気になった違いは、スピーカがない、電池駆動できない、あとSyncOutがないことですね。

音はサンプリング波形を127持っているので、流石にいいです。MIDIキーボードに繋いで普通に演奏する音源として使えます。最近の音源の傾向として、WaveTableをLFOなどで変調させるものがありますが、(Vital、CyDrums)そういった音づくりのエッセンスをちょっと試せるのではないかと思っています。

303 DayなのにPro VS の話ばかりになってしまいましたが、動画ではメインでないので、ちょっと控えめに使っています。いろいろと遊べるマシンなのでもっと掘り下げていきたいと思っています。

Volcaを使ってやりたいこともたくさんありますが、ちょっと最近 Too Busy..

小型シーケンサ付き音源が好きなのは、それぞれがメンバーのバンドのような感覚がするからです。役割を考え組み合わせるのがとても楽しい!NTS-1のオシレータ開発も。いろんな音源を知ると開発にも役に立ちます。

そのうちマシンライブもやってみたい!

Mixed Nuts

今月ライブで演奏するOfficial 髭男dism”Mixed Nuts”のドラム練習動画を記録用に撮りました。

新しい試みをしていて、後々確認したいと思えるときは動画を撮るようにしています。動画を撮ろうとすると練習もより頑張るので一石二鳥だったりするし。。(特にフレーズを記録しておきたい)

熱帯Jazz楽団の”Machete”の時もそうでしたが、その時練習したフレーズが今でも役に立っています。やはり本番というのは大事ですね。いつも貴重な機会があることをありがたく思っています!

常々神経系と筋肉系の練習は別ものと思っていますが、今回は両方必要で、演奏中に集中力が途切れると、ちょっとヤバイです。ホッとしたところで失敗してます。

自分を適度に追い込んで楽曲に向き合うと、これが飽きた頃に次にチャレンジするテーマが自然と浮かんできます。

ということで、次はドラムンベースか!

Rumble of Ancient Times (RoAT) / NTS-1 mk2

8-Bit Noise Synthesizer とされる、SOMA Laboratory の Rumble of Ancient Times (RoAT) 。これのNTS-1 mk2カスタムオシレータ実装を試してみました。

https://github.com/tweeeeeak/nts/blob/master/ROAT/ROAT.md

まずネーミングがかっこいいですね。

SOMAのデモ動画からも昔のゲーム機の音をイメージしているように見受けられますが、実際はローファイというよりもプリセット波形のデジタル変調(XORなどの演算)によるノイズで、どちらかとえいばリッチなノイズを生成します。(NTS-1ではFMはなし)

昔のゲーム機の効果音といえば容量の関係でサンプリング波形は使えなかったため、急激にピッチを変えたり、ノイズジェネレータを使って工夫して作っていました。

このシンセの操作は多数のパラメータをページ切り替えして設定するため、ただですら難解なのですが、つまみが少ないNTS-1に移植されているため、さらに難解になっています。NTS-1とNTS-1 mk2の両方バイナリーが配布されており、mk2の方を使用しました。mk2はページが数字表示のところが文字列に変更されており、パラメータ選択をドキュメントを見なくてもできるようになっています。パラメータの設定結果がどの値を指しているかは、つまみの位置で判断しなければならないので、ドキュメントは必要です。

(上記サイトより引用)

これが気に入ったのは、4OSC、4LFOのミックス具合で音が変調されるので、ボタンによるミュートで音が変化することです。(ON/OFFが反転する)

カスタムシーケンサを使ったとき、外部の機器と同期ができないこと、アルペジオレータなどのピッチ情報を無視することが、ちょっと残念でした。外部シーケンサを使えうという手もありますが、ちょっと処理が重く感じました。

デモをするにあたりどのパラメータを操作するか悩みましたが、次のようなプランを考えましました。以下メモ。

4OSCの同時再生を一つずつホールドでやるのが変化の面白みがなさそうなので(実機なら同時の押せるが・・)、シーケンサでリズムを作る。

かなりノイジーになるので、Summing Algorithmはおとなしめのものを選択。中くらいのバードさ。(Subtraction 2/Diagram 2) これを途中で変化させるには、パラメータが深すぎ。

SHPEにはFrequency、ALTにはWaveformをアサイン。

対象の切り替えをダイヤルでやるのは困難なので、どちらもLast Pressを操作対象とする。

各OSCのピッチを下げて消音の代わりに音を小さくした。

Last Pressが操作対象になるので、それが選択されているか、音を聴きながら確認して操作。(ピッチと波形変更)

(EGはOpen)

できるだけ多彩な音色が出るようにプレイしました。

いろいろと制約はありますが、音はかなりいいです!リバーブは HALLを薄くかけています。

まだまだ使いこなすには時間がかかりそうです。

ダイヤルは二つしかないのですが、このようなことを実現できてしまうことに、NTS-1のポテンシャルの高さを実感しました。(NTS-1の通常の使い方と異なる)移植した人のスキルもかなり高い!

以前簡易FMのオシレータを作りましたが、演算による変調はNTS-1では比較的簡単に実装できるので、またカスタムオシレータを作るモチベーションが湧いてきました!

mk2, NTS-3 で、LOGUE SDKをまた使いたいと思います。

https://beflat.iiv.jp/xml929

参考

https://fukusan.com/products/soma_laboratory/roat/

https://somasynths.com/roat_demo/

https://fukusan.com/products/soma_laboratory/roat/

https://somasynths.com/roat_specs/

Music AI

このブログの大きなテーマはAI時代の音楽の役割を考えることですが、ついにここまできたかと、SUNO という音楽生成AIについての話題です。

下記みのミュージックさんの動画がとてもわかりやすく解説されています。

歌詞も作るし歌も歌う。ペルソナ機能でボーカリストの個性を引き継いで楽曲制作できる。

みのミュージックさんは、音楽の知見が豊富でよく動画を見ていますが、彼のプロンプトエンジニア力がすごい。AIもすごいですが、使う人の力量が大きく左右するものだとあたらめて実感しまたした。

一番驚いたのは、ボーカルの音のクォリティの高さです。(このまま使える)

ポップスミュージックの新曲と言っても90パーセント以上は同じ音楽的要素でできています。逆にこれだけ同じなので、安心して聴けるのかもしれません。(先を予測できる)過去のデータからバリエーションを作るのが得意のA Iには、曲作りはうってつけなのでしょう。

この先は、楽曲データとして、スコアなりを出力し、人間が演奏すれば、AIを作ったとは誰もわかりません。AIが作曲サポートをすることは当たり前になりつつあります。しかし音楽制作がAIにとって代わられるようになっても、生で演奏する需要は無くならないでしょう。

(音楽における歌い手や演奏家の役割は代わらない、DJのパフォーマンスなども同様)

さらに進んで演奏家と区別がつかないロボットが出現したらどうでしょうか・・

これは音楽に限らないですが、そこには有機体の優位性がある、と思っています。

今でも精度を求められる研磨などの作業は、機械ではできません。エネルギー効率も優れています。( DeepLearningの消費エネルギーは膨大)

さらにさらに進んで、ロボットでなくクローン人間のような有機体だとしたら・・

そこは、美学、哲学、伝統、宗教といった価値観を持てる優位性がある、と思っています。

逆にこれらに根ざさない思想、信条はAIに凌駕されやすいかもしれません。

ちょっと飛躍しましたが、人類は簡単にAIには負けない、人間を含めたこの世界を設計した存在が作ったあらゆるものを、人間が真似をしているだけなので、オリジナルを超えることは不可能と考えています。

(ゲームを自由に作れるゲームを作ったクリエータをプレイヤーは超えられない)

過去の記事でも書きましたが、音楽はこれまでも時代の先を見通す鏡となることが多くありました。

音楽を表現するということは、さまざまなことに気づかせてくれると思っています。

音楽を表現したい欲求、これは楽しいことなのでAIなんかに誰もやらせないでしょう。面倒なことや人手がないことをAIにやらせればいいですね。

お気に入りの曲の伴奏を作ってもらい、歌を歌うとかソロ楽器を弾くとか・・

JAMuary 2025

あけましておめでとうございます!

今年もJamuaryにちなんでJAMってみました。

最近、音圧が欲しくてMoogのDFAMとかBehringerのEDGEなどを買いたいと思っていたところ、VolcaにもKickがあるのではないかと思い出しました。しかも安価で十分な性能があります。どうしても新しいものに目が向いてしまいますがちですね。パクリいや復刻が得意なBehringerの製品などは、食指が動くものが多くあります。Volca Bass, keys も以前からとても音がいいことを知っていましたが、やはり古いということで、もっといいものが出るのではということから敬遠していました。

「ちがうちがう、そうじゃ、そうじゃない」と再評価して、発売から10年以上たっていますが、手にいれました。

独立したシーケンサを同期させてのプレイは、前から好きなのですが、最近またその面白さを再確認しました。これまでのVolcaと組み合わせて、今年はもっとクリエイティブに音作りができそうです。(動画ではもっとVolcaをつなげたかったのですが、ケーブル不足)

1つ目の動画では、海外からもすでにいくつかコメントをいただきとても励みになります。久しぶりのVolca Modularを持ち出しての動画ですが、Volcaの全てのシリーズに改めて、そのポテンシャルの高さを感じました。最近新製品が出ていないのが寂しいですが(Roland,Behringerはこのクラスの製品を出していますが・・)、出るのならこのModular 2を期待したいです。Kastle DrumおよびBastleの製品が積極的にこのジャンルで存在感を示していますが、まだまだこのジャンル需要があると思います。

Volca Kick, Bass, Keys は、Volcaの中での音圧トリオと思っていますが、凄まじい音がでます。今回録音したときのモニター音と動画で聴いた時の音がかなり違い、バランスが非常に難しいことを知りました。もっと研究が必要です。

1つ目の動画は、運気がどんどん上がるように、2つ目の動画は、年の初めに大暴れしてみました。(邪気払いにどうぞ)

本年もよろしくお願いします!

Mid Manhattan

恒例となってきたライブハウスのカシオペアコピーバンド。

明日の本番を前に、練習のモチベーションを上げる一環として動画を作成してみました。

神保さんの名曲「ミッドマンハッタン」(当時こんな楽曲もつくれるドラマーということで嫉妬)はアドリブで叩くところがたくさんあるのですが、フレーズのアイディア出しをまずやる必要があります。

Roland Aira Compact S-1でオケを作ってそれをループさせて自由に叩いてみました。

(3テイクを一つに結合)

テンポが速く”迷ったら終わり”なので、手癖に逃げてしまうところなど、動画をとると反省点がよくわかります。

最後はこんな練習をしてみたい、という方のために、伴奏のみをおまけとして追加しました。

S-1は普段こういうことに使わないのですが、64ステップの音を入力できるので、ギリギリつくれました。(LFOもDelayもいい感じで基本性能が高い!)この曲、オンコードがきれいなフレーズですね。

ツインペダルは古いものですが、ライブ用にはいつものエレドラ用のTAMAのものでなくビーターが重いYAMAHAのものを使用しています。

追い詰められて叩くと、手癖もあるのですが初めて叩くフレーズとかでてきて面白いです。

High B

ハイベー、金管楽器でよく聞く言葉ですね。初心者は高い音を鳴らすのに苦労することから、この音が鳴ことが一つの目標になっている気がします。

金管楽器素人でしたが、夏頃より複数のバンドで需要があったのと音楽製作にも使ってみたかったので、始めてみました。(トロンボーン、トランペット、フレンチホルン)

YouTube動画では、たくさんの参考動画がありますが、皆さんそれぞれのコツの掴み方が様々で、教え方に個人差があることが興味深かったです。口の中が見えないこともあるのでしょう、説明がとても難しそうです。(しかも喋りながら教えられない)

ここでは、私なりに試行錯誤したことをメモしておきたいと思います。

(左からホルン、トランペット、トロンボーンのマウスピース。音色を特徴づけるためとても重要なパーツ。トロンボーンにトランペットのマウスピースをつけるとトランペットの音がする・・)

まずトロンボーンを始めました。音はすぐ鳴りましたが、1オクターブ以上はなかなかなりませんでした。

こんなに難しいのか、と挫折しそうでした。マウスピースが大きい分、高い音は口の穴を引き締める力が必要とわかり、これを意識したら少しずつ音が出るようになりました。しかしHighB(Bb)は1音のみ集中してやっとなる程度で、演奏には使えません。

スライドも難しく、瞬間移動しないと音がつながってしまいます。早いフレーズはかなり練習を要します。

スライドが連続的なので、バイオリンのようにピッチ合わせが繊細なのかと思っていましたが、倍音列で音がはまるので、そのようなことはなかったです。しかし息の強さで音が変わるので、今どの音が鳴っているのか、よくわからなくなります。

しかしなんといっても中低音好きな自分にとって、魅力的な楽器です。

次に、マウスピースの違いを体験したいことや、代表的な楽器を知っておく必要があると思い、トランペットの練習を始めました。最初にマウスピースのみで音を鳴らした時の炸裂音がすごいと思いました。これがトランペットたらしめているのでしょう。これも高い音を鳴らすのが難しく、あまりやりすぎると頭の血管がキレそうです。ハイトーンの出し方も動画によるといろいろあり、角度を変えて息を当てる方法は、比較的にうまくいきました。個人の口の形にも影響するようです。

3つのバルブによる音階はすぐに慣れました。木管楽器のように順に指を押さえることによる音程変化の方が直観的でわかりやすいと思っていましたが、意外とこちらの方が好きになりました。

3つのオンオフで表現するということはコンピュータでいえば3Bitで8とおりしか表現できませんが、複数の音が倍音列として鳴るので十分足ります。トロンボーンのスライドが7ポジション(7とおりの管の長さ)ですぺて表現できることと同じですね。

2:1:3(バルブ1,2,3)という比率の管にバルブを押すことによって流れを迂回することで、管の長さを変えて音程を変えます。1,2同時押しと3は原理的に同じ長さになるため、替え指になります。ユーフォニウムなどの大型金管楽器も同じバルブで、原理も同じです。

(これ考えた人天才だな)

最後にマウスピースが上記二つと全く違うホルンについて吹奏感がどうなるのだろうか、と興味をもちました。トランペットのものより小さいのに低音がでます。角がない丸くやわらかい音色が特徴でとても好きです。

ここで一ひねりして通常のフレンチホルンでなく、ベルが前を向いているマーチングフレンチホルンを選択しました。トランペットと同じBb管で運指も互換があり、演奏スタイルも同じだからです。(左手でバルブをおさえるホルンとちがい学習コストがさがる??) F管のホルンの楽譜を読むときは変換が必要になりますが・・

フリューゲルホルンやコルネット、メロフォンと間違えられやすいですが、これらはトランペットの部類で管もホルンより太く明らかに音がちがいます。トランペットの音の角をとった感じです。メロフォンはマウスピースをトランペット用のものからホルン用(要アダプタ)に変えて代用するものもあるようです。

音出しですが、2オクターブは比較的楽に音がでました。ただ演奏がとても難しいです。わずかな息の強さの変化で音がひっくり返ります。倍音列の上下に音がずれる・・ これを克服するために口の中の容積を大きくして、まっすぐ息を出すことを意識したら(手のひらに丸い息をあてる練習)安定しました。が、デリケートなので一音一音すごい神経を使います。

マウスピースが小さい分、わずかな空気の流れの変化が影響を受けやすいのでしょう。

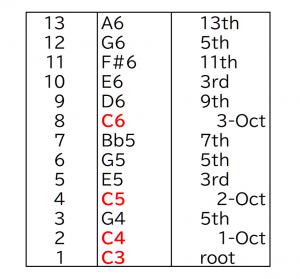

自然現象である倍音列の知識は必須ですので、これも学習しました。

わかりやすくキーCで書きましたが、実際はBbです。

トロンボーンは一番手前のスライド位置、トランペットとホルンは3つとも押さえない状態で、これだけの音がなります。

倍音が上の方に行くと、平均律と音がずれていきます。8倍音以上はリディアン7thスケールとなり、ポジションを変えることなくスケールをつかったメロディが演奏できることになります。高音で息が苦しい中わずかな息の変化で音程を変える・・通常は、2オクターブプラスアルファの範囲で演奏するものと思っています。

コードでいう7thと、9th,#11th,13thのテンションがちょうど倍音の番号と一致しているのを知りませんでした。これは偶然なのでしょうか。

バンド以外での使い方は、ホルンではピアノ伴奏でソロ演奏など雰囲気よさそうです。カフェライブでやってみようかな。

あと制作用途では、下記の動画のようなことがやりたいです。

DJやモジュラーシンセを使ったライブの中で、効果的に金管楽器を演奏してみたいです。TAKUYA NAKAMURA氏はジョジョメイヤーのバンドでキーボードをやっていました。ジョジョメイヤーがドラムンメースに目覚めたのは、彼の影響が大きいのかもと思っていますが・・センスあります。

音楽の楽しみで、曲を作ること、演奏すること、聴くこと、がありますが、これを同時に楽しめるこのような形態に憧れます。(一杯やりながら・・)

あと大好きなメタファイブのようなものでしょうか。テクノのようなジャンルだとラインでないアンプラグドな空気感が逆に新鮮です。いろんな質感の音が混ざっているのは好み。

とてもクール!

なぜ金管がいいのか考えたとき楽器自体タフだし、倍音列の仕組み自体が離散的で、デジタルっぽく、エフェクティブに感じました。

この三つの金管楽器は、イベントに合わせて今後も続けていきたいと思っています。

練習環境も、ベルを押さえると音がかなり減衰するため、サックスに比べれば自宅で音は出しやすいのと。マウスピースだけでもいい練習ができそうです。

インナーマッスルや心肺機能の強化にもなるかも。。

Noisevember 2024

朝起きて、Noisevemberの動画投稿をしていないと気づきました。(下記参考)

https://beflat.iiv.jp/xml927

今日が11月最後なので、何をやろうかと急いで考え準備。

最初、VolcaFMとVolcaDrumで、デジタルノイズっぽいのもいいかと思いましたが、ダイナミズムに欠けると思いアナログでいこうと思いました。

ラジオノイズを無線機のスケルチ設定のギリギリにすることで、ランダムにノイズを出すようにしました。

最後いい感じで締めくくりました。

ちょっとストーリー性に欠けますが、今回はこんなところで。。

爽やかな朝でした、Have a good day!

Lupin The Third

ルパン三世のテーマ、アップライトベースを買ってから一度は演奏してみたかった曲です。

今度ライブで演奏することになり、練習しました。

どこをとってもクールなフレーズでとても好きなのですが(一部アレンジしてます)、残念ながらまだ一度も失敗せずに演奏したことがありません。

フレーズ間違いは減ってきているのですが、弦の力加減を間違えて、発音が十分でなかったり、引っかかって音が遅れたりしてしまいます。

動画をとることで本番の気分で挑戦しよう思い、あえてとってみました。

前回とった動画から4年になります。

https://beflat.iiv.jp/xml311

私の先生のアドバイスにより、人差し指の根っこから弾くようになったことは、ちょっと進歩したかもしれません。

今回も練習の成果として、動画に残しておきたいと思います。

撮影メモ)

Roland MC-505

久しぶりにリズムを打ち込んだら、キーボタンがチャタリングを起こしていて、こんな壊れ方するのだと驚いた。音は問題なし。

Zoom B1 Four

MC-505の音をAUX-Inしてミックス。プリセット130’GlamComp’を使用

あと、iPhoneのシネマモードで後からピント調整できるのは、こういう奥行きのある動画撮るとき特に便利と感じた。

Mellow and Tight

今年も恒例のドラムマガジンコンテストの曲を演奏してみました。

第一印象は苦手なテンポだなあ・・と思いました。いつも今回はどんなテーマでやろうかと考えるのですが、最近はツインペダル強化月間なので、これを使えるフレーズでトライしてみました。

昨年はずいぶんと凝りましたが、今年はあっさりと。

Hot for Teacher

前回のツマミスト宣言の後、次のテーマはドラムセットを叩きながらやることを考えました。

実は、以前からこれに少し挑戦したことがあります。

叩く動作とツマミを回す動作を同時にやるって結構難しく、修行が必要だと思いました。

この時一瞬ではなく、フィルタを継続的に回したかったのですが、右手がずっととられるとパターンが貧弱になることから諦め、その後いろいろと考えを巡らす日々が続きます。

そこで思いついたのが、ツインペダルをもっと有効に使えないかということで、

フットハイハットと左足BDの同時踏みで、右手なしのハンデを感じさせないようなパターンを作ればいいと考えました。(このチャレンジはまた次の機会に)

これをきっかにツインペダルおよひツーバス奏法についていろいろ考えていると、随分昔からあるにもかかわらずまだ成熟していないのではないか、と思い、もっと深堀したくなりました。

試しに前回のライブでは、カシオペアの曲のドラムソロにツインペダルを使ったりしました。

これまでは一般的な連打系や、YMO UT動画でダブルストロークをやっていますが、

左足を軸としたものをやるのに何かいい題材はないかと探していたところ、そうだ、これがあった、と思い出しました。

このドラムパターンを使った楽曲をこれ以外に聴いたことがないのですが、それだけインパクトがあり、とても好きな曲です。

名曲揃いのVan Halenの中でも、とてもオリジナリティがあり、”Why Can’t This Be Love” と並んで私のBest 1 です。

また似たリズムの曲としては、これが好きです。

めっちゃかっこいい!

ちょっと前の朝ドラでBoogie-Woogieの曲をやっていましたが、Boogie-Woogieをドラムで叩くと大体、スウィングになるのですが、自分はツーバスのパターンで叩くべし、と思っています。

先ほどツーバス奏法について、まだ成熟していない、といいました、結局活躍する曲が少ないことが原因なのでしょう。ハードロック系の速い曲の連打とかドラムソロとか。成熟していない、ではないですね、まだまだ開拓する余地がありそうです。

ということで、Hot for Teacher のドラムイントロに挑戦してみました。

下記、楽譜を参考にした動画です。

オリジナルはBD2台オーバーダビングをしているので、厳密には一人ではできませんので、いろいろ変えています。(BDとFloorTomに)2パート目が入ってくる部分、シャッフルとフラットリズムでかなり困難なので、キックがシャッフル、手はシャッフル気味のフラムアクセントにしています。バイク(ハーレーダビッドソン)のマフラー音を模しているとのことなので、それっぽくするため、三連符は手でなくキックで入れています。

かなり難しい!

まだまだ修行が・・

KAOSSILATOR & NTS-1 (Logue SDK) Demo

久しぶりにKAOSSILATORを使ってみました。

きっかけはNTS-1のmkIIが発売されるということで、いろいろ調べていたところLogueSDKで過去にFM音源をつくったことを思い出し、mkIIではエフェクタを作りたい、と思うようになり、しかしmkIIがなかなか入荷しないので、今のもので作ってみようか、ということで自作エフェクタをつくりました。この効果をためすべく音源を何にするかと最初はVolca Sample にするつもりでしたが、最近動画でKAOSSILATORが現役で活躍するのをみかけ、これでもいいなと思い使いました。それ以外にも、X-YパッドによるMIDコントローラを使いたいアプリが最近あったことも影響しました。影響というのは内的なものではなく、検索で調べていた結果、YouTubeのレコメンドに反映されたかもという外的なものです。(この現象はやばいのか、便利なのか・・)

久しぶりということでまずは約15年前の動画です。

「KAOSSILATOR with iPhone ‘Dr Metronome’」

自作iPhoneアプリのデモもかねて、人力同期の涙ぐましい演奏です。

音がいいので、これだけで曲を何か作ってみたかったのでしょう。メトロノームの小節数だけみて他のフレーズをイメージしながらソロプレイをしたと思います。

動画は、MacBookの内臓カメラとAudioInで撮ったと思います。ちょっとズレていますが、感慨深いものがあります。

今回、Logue SDKで作ったエフェクタは、リバースとリピートです。

コードの説明は下記。

「KORG Logue SDK」

https://decode.red/ed/archives/1581

エフェクタのイメージは下記の動画がベースにあります。最終出力段にかけてリズムを変形させる狙いがあります。

スライサーも作ったのですが、モジュレーション系のエフェクタになりリバースと同時に使えないことと、効果が大きいことからリピータにしました。

「Volca Sample2 Jam w/ SL-2, RC-5, KeyStep37」

Logue SDKをつかった過去動画

「KORG Nu:Tekt NTS-1 Custom Oscillator」

さて今回の動画ですが、「Volca Sample2 Jam w/ SL-2, RC-5, KeyStep37」よりかなり安上がりになっています(笑)

今回の動画は個人的にとても意味があるものとなっています。DJコントローラがとても好きで、素人ながらいじったりたまに動画をとったりといろいろ試しているですが、サウンドの最終出力段にかける操作(エフェクタ)の責任の重さというか緊張感が演奏と同じ感覚に感じるからです。

DJではターンテーブルやクロスフェーダの操作タイミングでリズムをコントロールしますが、とてもセンシティブです。前回のLFO操作も同様ですが、ツマミにもそういった要素があります。今回の動画でいうとツマミ操作のわずかな差で、リズムが大きくかわりとても神経を使います。つまりツマミも楽器ということですね。

「ツマミスト」と勝手に呼んでいます。

今までもレゾナンスとフィルタのツマミをバランスよくいじって、気持ちいいTBサウンドを得る難しさを経験していますが、リズムはそれ以上の難易度があります。そのためSDKのプログラムコードも自分の操作感にあうようカスタマイズしました。

テンポが同期できれば、その倍数でリズムをコントロールすることで安定したプレイも可能ですが、そうでない方が好きです。前回動画のS-1のLFOにもその機能がありますが、あえて使っていません。X-Yパッドやフェーダのようなものの方が良いか、とも考えましたが人が操作する精度面を考えるとツマミの方が良さそうです。X-Yパッドは音色の変化には向いていますね。

まだまだいろいろと改善の余地はありますが、これからも精進いたします。

ツマミストとしての第一歩でした。

AIRA Compact S-1 & Volca Sample2 Jam

これまでKorgのVolcaシリーズをよく使ってきましたが、今回RolcandのAIRA Commpacシリーズをはじめてトライします。

S-1の第一印象ですが、エフェクタが高音質なのとバッテリ駆動、MIX-INがいいなあと思いました。購入の決め手はオシレータのDraw、Chopとディレイエフェクトです。

Rolandのデジタル音源はバランスがよく音がきれいですが、汚れ系が好きな自分にとってはこの二つの機能が魅力です。

ということでノイジーな音をしかも短音のみ使ったデモ動画をとってみました。最近LFOでリズムを作ることが好きで、S-1では存分にできます。

あと最近撮った動画について。

YouTubeでは、コンパクトシンセを使った動画が多数ありますが、その中でもイベントがいくつもあります。

1月のJamuary、3月3日のRoland TB-303のクローンによる303Dayなど、ついつい動画をつくりたくなり私もアップしました。(ちょっと遅刻しましたが・・)

最近、11月のNoisevember というものもあることを見つけましたが、またアップしたいと思います。

世界中の人が、こうやって同じテーマで動画を作るのって、本当に楽しいですね。

PC Keyboard Layout

まず前回動画での操作説明ですが、VSCodeからSonicPiを起動する仕組みは下記を使いました。

“LIVE CODING BY VSCODE”

https://decode.red/blog/202211051504/

またVSCodeにVimの拡張機能を入れました。

これらにより、SonicPiについてはCtl-s/Ctl-e で演奏のStart(Save)/Stop、エディタの機能としては、Ctl-a/Ctl-x で数値のインクリメント/ディクリメント、gbでマルチカーソルが使えるようになります。基本的な操作はviエディタの操作がそのまま使えます。

ここから専門的なつまらない話になりますが、経緯の記録として残しておきます。(蘊蓄だらけですが ^^;)

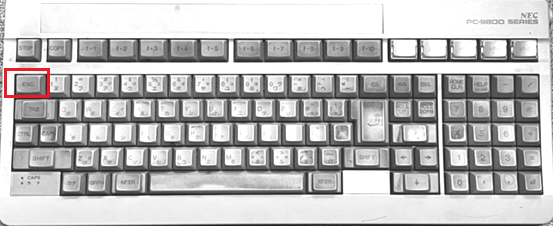

なぜVSCodeのような高機能エディタを使っているのに、viのような古典的なエディタの操作を使うのか(すべてのケースではない)、ですが、これはキーボードのチョイス、キーボードレイアウトのチョイス、諸々から影響を受けた結果によるものです。さらにさかのぼってCUI時代の利便性がGUI時代でも生き続けている証拠でもあります。

まずはキーボードのチョイスについてです。カスタム配列、分離型などの高級キーボードに憧れ、情報収集はしたもののキーボード沼にははまる手前で踏みとどまっているところです。

踏み留まる理由

1) カスタムに慣れてしまうと他のキーボードに対応できなくなる。

2) 数万円という高価である。Mac,Linux,Windowsそれぞれ複数台あるためキーボードも必ず複数台欲しくなる。

そこで販売されているものの中でできるだけ安価で好みに近いものにするため、下記カスタマイズ自由度(①から⑤)に注目して選ぶことにしています。

キーボードレイアウトについては、日本語配列よりUS配列のものの方が品数が豊富です。※①

またプログラマにはUS配列の方が記号キーが合理的であることがあります。

まだワープロがパソコンのアプリよりも使いやすかった時代から始めたせいもあり、日本語はかなキー入力からはじめました。50音それぞれキーがあるので母音・子音の組み合わせでタイピングするローマ字日本語入力より速いというメリットがあります。デメリットはキーが右側に多くなり、センターが左よりになりEnterキーまでが遠くなります。USレイアウトにするため、かな入力をやめました。とはいっても日本で発売されているPCはほとんど日本語レイアウトなので別売のUSキーボードを使用します。

最近ようやく自分が理想とする配列をもつキーボードに出会いました。これが前回動画で使用したものです。

ファンクションキー、テンキーがないもので、バッククォート、チルダが単独キーのものです。特にこの二つのキャラクタはシェルコマンドでとても重要です。ファンクションキーがないものはESCキーと兼用になることが多く、これは避けたいところです。しかしながらESCキーはこの位置が好みです。これはPC-9801の時代にvzエディタを使っていたことが起因するのですが、ESCキーを多用するところはviも共通しています。MS-DOSからWindowsに移行したとき(DOS/V仕様ESCキーがファンクションキーの左になるIBM互換機にも移行したため)、次のエディタがなかなか見つからなかった記憶があります。

あとWindowsの場合PowerToysで、Macの場合Karabiner-Elementsで、下記のようにキーアサインします。これらのツールによりキーボード本体に保存機能がある機種を選ばなくてもよくなります。※②

CapsLk -> Ctl

Alt w -> ↑

Alt s -> ↓

Alt d -> →

Alt a -> ←

Alt q -> Home

Alt e -> End

Alt r -> BS

Alt f -> Enter

Alt x -> DEL

すべて左手側にこのようなキーをもってくるのは、ホームポジションから離れないようにという利点以上に、右手がマウス操作でふさがっているときも使用できるからこのようにしています。

手がホームポジションかははなれることを嫌うカーソルキー専用キーを使わない文化は、viエディタからあります。コマンドモードによるキー操作が可能であるため、j,k,l,mでカーソル操作をします。(カスタマイズは、できるだけデフォルトからはなれないように、いろんなプラットホームでつかえるように、を心がけています。※③)

viエディタは、Unixマシンを使うときこれしかなかったから使い出したのがきっかけですが、その合理性は今の時代にも生きています。。

とくに最近マークアップ言語のおかげでHTMLに変換する文章を書く際に利用しています。

https://decode.red/blog/202401061739/

ブログを書くのに、コンソールだけで、マウスを使わず作業を完結することも可能です。キーアサインのカスタマイズや拡張キーボードで利便性を追求する流れもありますが、

viの機能で補うことで実現ができる部分も多いと感じています。※④(動画編集やドロー系のアプリなどはまた別ですが)

メカニカルキーボードはキーキャップが変えられるので自分好みに近づけられます。※⑤

好みは赤軸ですが、レイアウトを優先しているため今のところ青軸のものを使っています。

(打鍵音は青軸が好きです。上記動画の音)

音楽キーボードの関係ですが、シーケンサなどのキーボードとして横一列を白鍵とみたて斜め上を黒鍵とした使い方がありますが、私はあまりこれが好きではなく、A,B,C,D,E,F,G が左にあることを利用した使い方をしたアプリを作ったことがあります。。

http://iphone-old.iiv.jp/sound/index/L0035

最近はクロマチックキーボードに興味を持ちこれを模したキーボードをキーキャップを変えて作りました。

このようにできるだけ好みに近づける工夫をして利用しています。

(この先沼にはまるかもしれませんが・・)

ここまでに登場したキーボードはE-YOOSOというメーカーのもので、気にいっています。Z-11,Z-686それぞれ色違いもあわせて計四台となります。(上記動画でない方↓ キーキャップをとりかえてます)

できれば理想とする配列のキーボードのもっとダーク色のもので赤軸が欲しいところですが、いまのところ満足しています。

ライブコーディング、カスタムキーボード、viエディタ、マークダウン これら表現する道具として、近い関係と感じているこのごろです。

Glitchy Style / Live Coding

Lenny “The Ox” Reece というドラマーの名前を下記で少しふれましたが、今回は彼のプレイからいろいろ話を膨らませてみました。

https://beflat.iiv.jp/xml858

まず彼に関する動画の引用から。

最初、動画のタイムラインをいじっているのかなと思ったくらい不自然に見えました。しかしその機械的というか独特なノリに新しさを感じました。

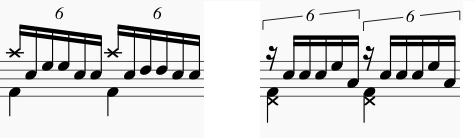

彼のプレイを譜面に起こしたものですが、とてもチャレンジングです。

https://drumsmagazine.jp/notes/next-generations-5/

さすがにドラムマガジンのサイトでも解析がされていました。

https://pearldrum.com/ja/artist/lenny-ox-reece

https://seelectronics.com/artists/lenny-the-ox/

こちらにプロフィールがあります。

ここにある”glitchy” style という表現がよくそのプレイを表していると思いました。

変拍子とはちがうちょっとバグった感じに聴こえるからです。

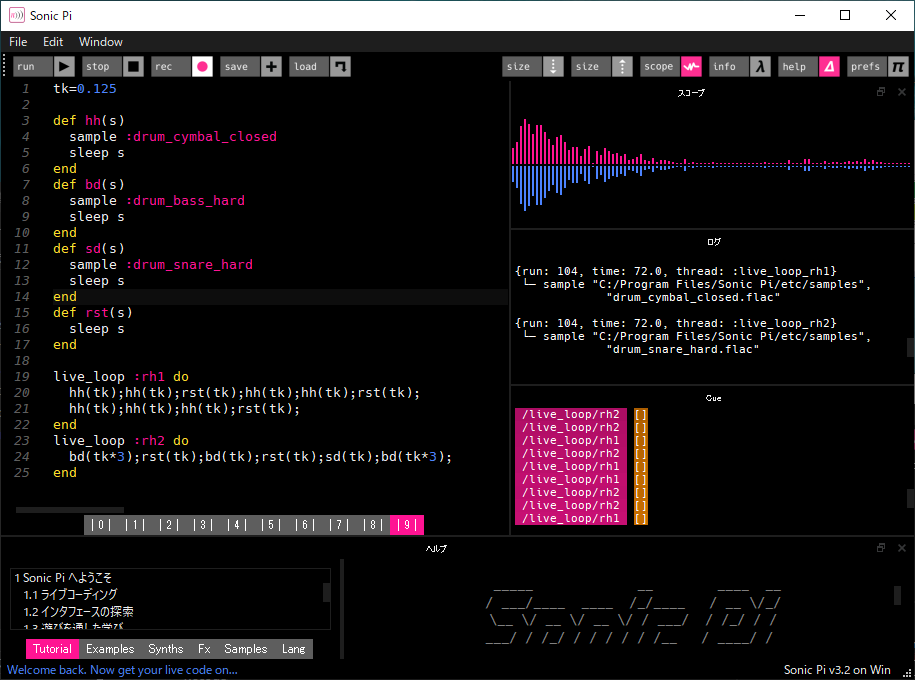

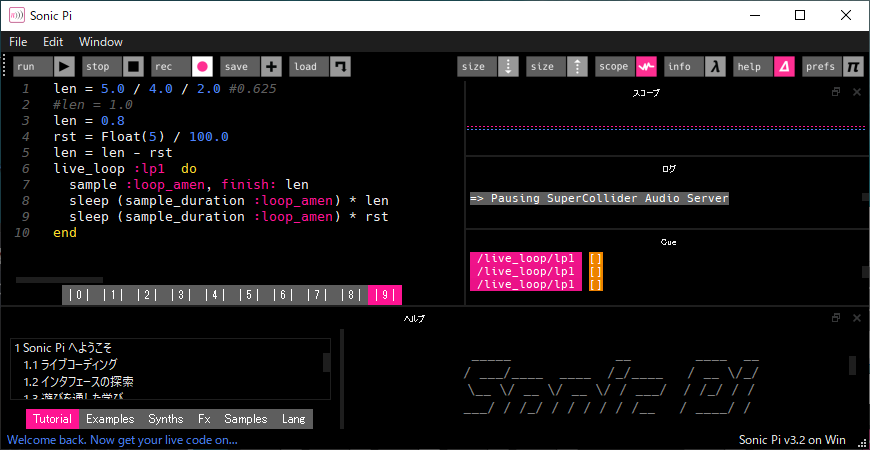

SonicPiでそのような雰囲気をまねてみました。

10/16拍子ですが、ずっと聴いていると違和感なく聴こえてきます。5,7のような奇数連符にしても整然とならべてしまうと同じ結果でした。また参考までに前回の動画のものは以下です。

きれいな変拍子ともいうべきか、すぐなじんできます。

バグっている感覚というのは、フレーズサンプリングのループがテンポにあっていないときの感覚に近いのではということで、それをまねてみました。

音的なニュアンスはちがいますが、自分の感覚的にはこれが近いです。

どんな音素材でも繰り返すことによってリズムを感じますが、ただしその繰り返す素材の長さは一定である必要があります。(素材の中身は一定である必要はなし。。工場のコンプレッサー、モータ音などや、むかしのパチンコ屋のネオン管の眺めているとそれだけでリズムを感じた感覚)

過去の動画でも工場風のノイズを楽しんだものがあります。(こういうの大好物)

最後にSonicPiにもどって、フレーズサンプリングがループサイズに足りていない様子をライブコーディングしてみました。

lenは、ループさせるフレーズサンプルの割合(1.0 = 100%) rstはそのうちの無音部分。

このしくみについては、次回とりあげたいと思います。

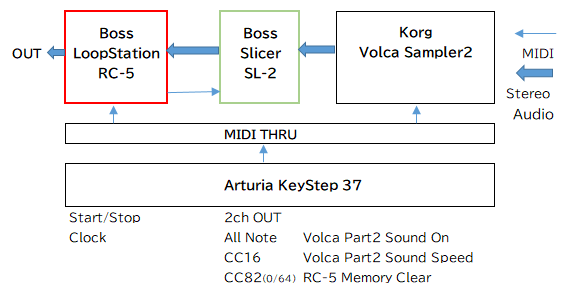

Volca Sample2 Jam w/ Slicer+LoopStation

Volcaシリーズの久しぶり動画です。DJミキサーとか使っていると、最終段の音を操作するダイナミズムに勝てるものがないとう感覚が増してきました。しかしDJのスクラッチやエフェクトは録音済の音源が対象なので、これをリアルタイムにできないかということで、スライサーとルーパーを使って遊んでみました。

肝はスライサーのテンポ同期です。DJエフェクトでも検出したテンポが影響するものがありますが、それに相当します。テンポマスターはKeyStep37で、Volcaシーケンサも同期させています。

ルーパーはリバース再生のために使い、シーケンサの拍子は5/8にしました。(変拍子なのはスライサーのフレーズとのズレを調べたかったのもありますが、次に予定している投稿に変拍子を扱うためです。)

今回はできることメモみたいになってしまいましたが、課題は、スライサーでもっとおいしいフレーズをつくれるようになることと、ルーパーのさらなる活用です。

コンパクトエフェクトは外部スイッチを充実させないと操作に限界があるため、MIDIコントロールをプログラミングしないとと思っています。(MIDIがついていてよかった)

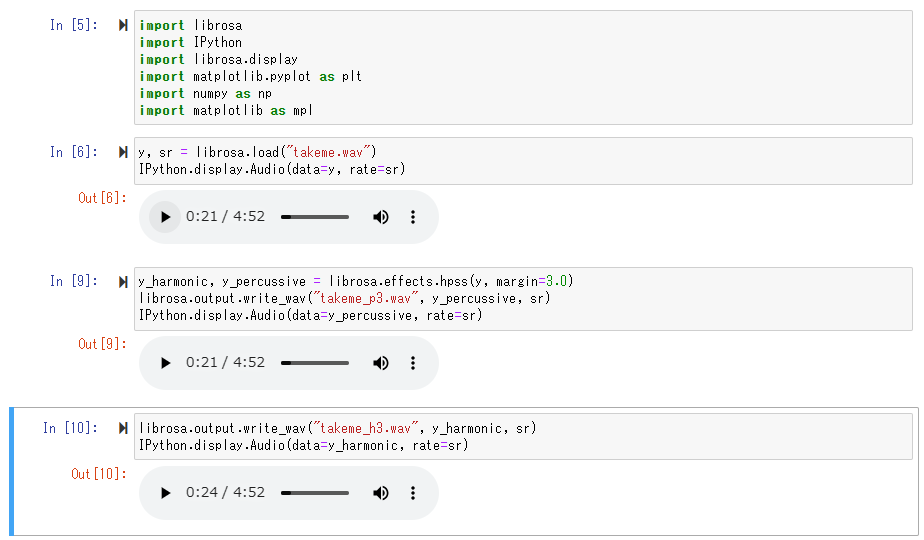

Hermonic-Percussive Source Seperation

日本語で調波打楽器音分離というようですが、前回につづき年末ライブの練習の過程で実用的につかってみました。

HPSSを使うと、ドラムパートとそれ以外を分離することができるため(ドラマー向けカラオケになる)、ドラムの練習に最適なのです。

実は、3年ほど前に下記で試したことがあります。

「LIBROSA SOUND EDIT」

https://decode.red/blog/202008111185/

今回、上記でテストしたPythonプログラムをつかって、カシオペアの楽曲「TAKE ME」の練習用トラックを作ってみました。(モノラルトラック)

マージンなし

Hermonic音

Percussive音

マージン=3.0

Hermonic音

Percussive音

アタックの強い部分とそうでない部分が見事に分離されています。これによりアタックの強いドラムの音が分離されるわけですが、

ドラム以外でもスラップベースのアタック音なども打楽器側として分離されます。

マージンの数値にとって分離度を変えられますが、この値を大きくすると調波側のアタックがなくなりすぎて、合わせてドラムを叩くのが困難になるためマージンはなしのものを採用しました。

(ちなみに、Hermonic音とPercussive音を合成すると元の音にもどります。)

曲によって分離後のクオリティが違いますが、「TAKE ME」はスローな曲ということもありとてもいい感じに分離できたと思っています。

Hermonic音にあわせてV-Drumsを叩いてみました。

※著作権で保護されている楽曲を使用する場合はご注意ください。私のYouTubeチャンネルは14年ほど前からブログの動画置き場という目的で使用しており収益を目的しているものではありません。下記動画についてはYouTubeからの注意メールがありましたが、収益目的化していない動画はそのままでよい旨を確認しております。(2023/11/19)

©Sony Music Entertainment (Japan) Inc.

あらためてこの曲、いい曲ですね。叩きながらしみじみと感動しました。

しかしながらドラマーにとって難しいテンポです。私はテンポ100BPMあたりに境界があると思っているのですが、ハイハットの16分音符を片手で叩くか両手で叩くか迷うからです。クローズドリムショットが4分音符の部分は片手で叩くことを強制されますが、それ以外の部分でも多彩なパターンも持った曲で、このテンポでは音数を増やすにしても減らすにしても間が難しく、とても練習になる曲です。(まだまだ本番までにフレーズを練らないと・・)

V-Drumsメモ

・クローズドリムショットのボリュームを上げたため、オープンリムショットを叩かないようにした。(音が大きくなりすぎるため)

・前回の「DOMINO LINE」でもあったが、オープンハイハットのフットコントローラーの反応が遅れる。調整が必要。

・スネアの音が詰まったような音がでるときがある。センサーの劣化か? 打点をもっと正確にコントロールする必要あり。

・ライドシンバルのセンサーが劣化してきている。

Domino Line / Casiopea

年末ライブハウスであのカシオペアの楽曲をむちゃくちゃ久しぶりにやることになり、その練習を兼ねてその中のDomino Lineという曲のドラムソロを動画にしてみました。1982発売の 「Mint Jams」というアルバムに収録されているバージョンで、過去に部分的に耳コピした記憶がありますがほとんど忘れてしまいました。(最後にとりあげる六連フレーズ以外。途中ドラムセットを叩いていないブランクが20年以上あるので・・)

譜面がなんとYouTubeにあったので、それをできるかぎり再現しました。

譜面付:Casiopea-Domino Line Drum Solo/カシオペア-ドミノライン-ドラムソロ

ソロなのにアドリブでいけないのか、このまま再現する意味があるのか、という思いもありましたが、ベースソロからドラムソロに流れる部分は、もうこれが曲そのものになっているので、これでないと、Domino Lineでなくなってしまうように感じたので、そのままやることにしました。

オリジナルと違う部分やまだできていないところ、自分なりに変えたところもありますが、とりあえず今の段階はこんなところです。(スネアの強弱をもっとメリハリ)年末までにもっとがんばらないと。。

ライブハウスにあるドラムセットがどのようなものかわからないので、それによっては雰囲気が変わってしまいそうですが、まあこれは仕方ないですね。

カウベルとホルダは持参します。

YouTube にこのドラムソロをそのままやる人の動画が結構あったのは驚きました。40年以上前の楽曲なのに根強い人気があることを実感しました。本当にYouTubeは探せばなんでのも出てくるものですね。

この流れで神保さんの近況も見つけました。

【神保彰】フルアルバム『燦燦』全曲インタビューをお送りします!

最新アルバムを早速購入しました。最近はダウンロードばかりなので、もしかしたら最後に買ったCDになるかも。それはそれで記念すべきがこのアルバムで嬉しいです。上記動画のインタビューも見ると創作過程が見えて興味深いです。同じレコード会社(アルファミュージック)だったYMOについてのエピソードがまさか聞けると思ってもいませんでした。(ちなみに私のゲーム音楽CDもココ)このようなクォリティの楽曲を軽々と作っているように思えるのですが、相変わらずさすがです。ドラムの方は私もYouTubeで注目していた、Lenny ‘The Ox’ Reeceがよく使う5連符、7連符のフレーズを全編に渡って散りばめています。下手すると、ズッコケたように聴こえますので、かなりのハイテクニックが必要です。

変拍子とはまた違い、また新しい可能性を感じます。ご本人曰く「研究発表」ということですが、音楽への向き合い方の一つの側面を感じます。これについては長くなるので、別の機会にまた記事にする予定です。

さらに過去動画がいろいろとヒットした中に、下記のような動画がありました。

Dave Weckl – Zildjian Day Tokyo 1996 with Akira Jimbo and Kozo Suganuma

こんなものが存在するとは知りませんでした。(レコメンドさまさま)すごい熱量のプレイをしています。実はこのお三方とも生音を至近距離で聴いたことがあります。

神保さんは、ドラムクリニックで、デイブと孝三氏は、YAMAHA BIG DRUMMER’S CAMP 1991(合歓の郷)のことです。

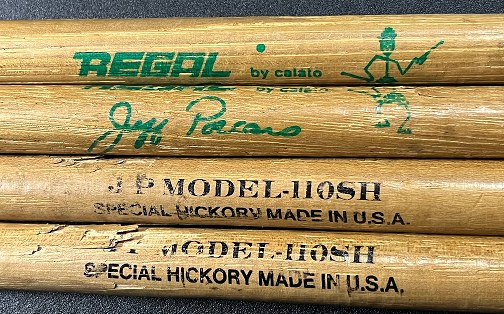

神保さんは予想していた音量より大きくハードロックドラマ並みとそのとき思いました。デイブはもう一人のゲスト講師のトミー・アルドリッジも一緒にプレイしたこともあり繊細に感じました。孝三氏については少し思い出話を。氏をこのキャンプの時初めて知ったのですが、自身のドラム教室の生徒さんもたくさん参加していたこともあり、なんか他の講師とは違って友達のような雰囲気で皆に接していました。講師の人からも人気で、通りかかると、「何かやってよ」と言われて、ドラムソロを叩いてくれました。私がたまたま近くにいたので、スティックを手渡すと「ジェブポーカロモデルか・・」と言って、叩き始めました。右手のスティックでバスドラと叩いたり、曲芸的なこともやり、みんなを大いに盛り上げました。ドラムで笑いを取るとは、すごいと当時衝撃を受けました。その後、氏の活動を多くのメディアで見ることになるのですが、いつも親しみを持って見ていました。

Drummer’s Camp は多くの講師が、普通に一緒の空間にいるので、気軽に接することができて、とても貴重な経験でした。デイブと一緒に写真を撮ったり、Tシャツを着たまま背中にサインをしてもらったりと、今考えるとすごい機会だったなと思います。デイブのドラムセットを叩くこともできました。

神保さんのクリニックでは、サイン入りポスターが結構参加者が多い中で抽選で当たって嬉しかったことも思い出しました。

想い出がドミノ倒しのように蘇りますが(うまく言ったつもり)、最初に戻って、ドミノラインのソロについて当時考えたことを書いて見たいと思います。

フラムアクセントやパラディドルのルーディメントが多用されていますが、これは明らかにスティーブガッドの影響によるものでしょう。神保さんが当時よく盛り上げるときによく使う6連符ですが、これに相当するフレーズがスティーブにもあります。

神保さんの頭のクラッシュはスティーブのハイハットクラッシュオープンでは弱いと判断しクラッシュにアレンジしたと勝手にみています。結果今のようなフレーズになっていますが、第一印象は違っていたのでは、という予想ですが、本当はコピーミスと思いたいです。当時は動画がないので音だけで判断しますので、ハイハットクラッシュオープンがクラッシュに聴こえたり、フロアタムがバスドラに聴こえたりしました。タムが6音中2つなっていますが、タムをダブルスストロークするためには、それなりのヘッドにテンションがあって、いい音でなってくれないと、クリアに聴こえないことから、神保さんのフレーズの場合は使うシチュエーションが限られます。ピッチの高いタムがあればなおさら良いです。(ライブハウスにあるような、大抵ロック用ドラムセットの場合ピッチは低めのタムなので、ニュアンスが変わります。)

スティーブの場合は、頭を抜くため手が一つあまり、タムを二つシングルストロークで叩くことができます。トレードオフとしてアタックが弱くなりますが、大抵のドラムセットで同じニュアンスになります。(この前のコンテスト動画の最後で叩く)

先ほどコピーミスと思いたい、と書きましたが、これにぱポジティブな意味があります。動画や譜面がなくコピーしようとすると、たぶんオリジナル通りにならないため、その差異が自分のオリジナリティになるからです。神保さんのドラムは、手が三本あるのではないかと思わせるようなフレーズがありました。(当時随分悩んだ)パーカッショニストがいないのに、なぜここでカウベルが鳴っているのだろうとか。どちらの手でどういうタイミングで叩いているのか、ハイハットを叩くのではなくクローズハイハットで鳴らしているのか、などなど試行錯誤することが、自分が新たなフレーズを作るときなどの参考になりました。

ドミノラインのネタから、随分話がふくらみました。

最近のことはよく忘れるのですが、昔のことはよく覚えているものです。

D5 Creation

D5 Creation