カテゴリー: 未分類

Ars longa, vita brevis.

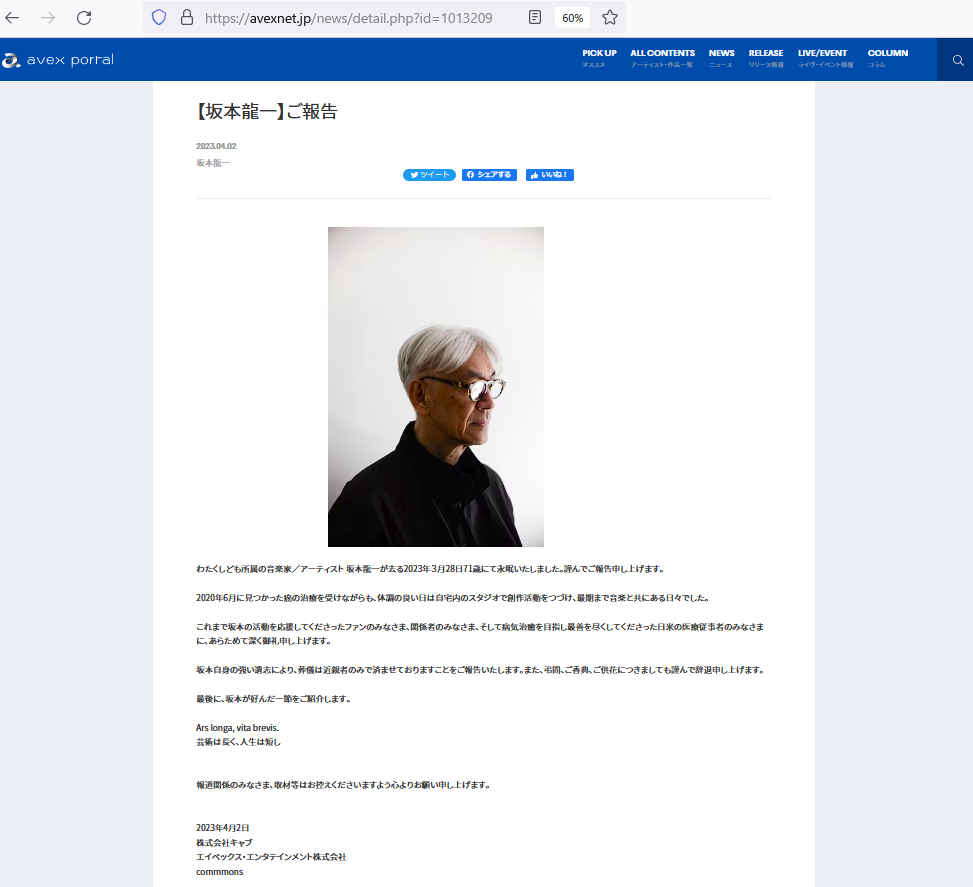

また衝撃的なニュースが飛び込んできました。教授の訃報です。

1月のユキヒロ氏の訃報から間もないこともありとてもショックです。

音楽に対する実験的な姿勢には、とても影響を受けました。このようなブログを書いているのも元をたどれば教授にいきつきます。

YMO時代のヒット曲も好きですが”B-2 UNIT”,”音楽図鑑”,”未来派野郎”といったソロ作品がとても好きでした。また”戦場のメリークリスマス”のような美しいメロディーも好きですが、シンセ、サンプリングを駆使したノイジーでマッドな教授にはとても刺激を受けました。音に対するあくなき探求には、そのベースには音という本質的にものに対するものへの好奇心、音に対する敬意があるからなのではと思っています。世界の音に対する興味、それは音という自然への興味であり、これが教授の環境問題などの活動に現れている気がします。こういう政治につながる活動は誤解を生みやすいので、表現が非常に難しいと感じたことがあります。(政治活動をする動機というのは人それぞれ違いますが、正反対の意図を持った人が同じ運動をしていることもあるからです。影響が大きい人は本意でない利用をされることもある。)

闘病をしながらの創作活動に、この人だからこそこのような偉業を残せたのだと確信しました。

人間だれしも死はおとずれますが、その人の思い出は残り続けます。タイトルの言葉は、インフォメーションからの引用ですが、今これを痛感しています。

あらゆる栄誉をすべて手にいれたようなアーティストで、これに憧れて関連する様々なことに関心をもつこととなり、そのおかげで充実した音楽ライフを過ごせました。

ご冥福をお祈りいたします。

Ars longa, vita brevis.

Ars longa, vita brevis.

「芸術は長く、人生は短し」

4月8日追記

Prompt Engineering

生成系AIが最近話題になっていますが、私も下記ブログでいくつか取り上げました。

ChatGPT

https://decode.red/ed/archives/1314

Stable Diffusion

https://decode.red/ed/archives/1335

Text2Music

https://decode.red/ed/archives/1349

これらすべてテキストでAIに対して指示を出して、その結果を得るものです。

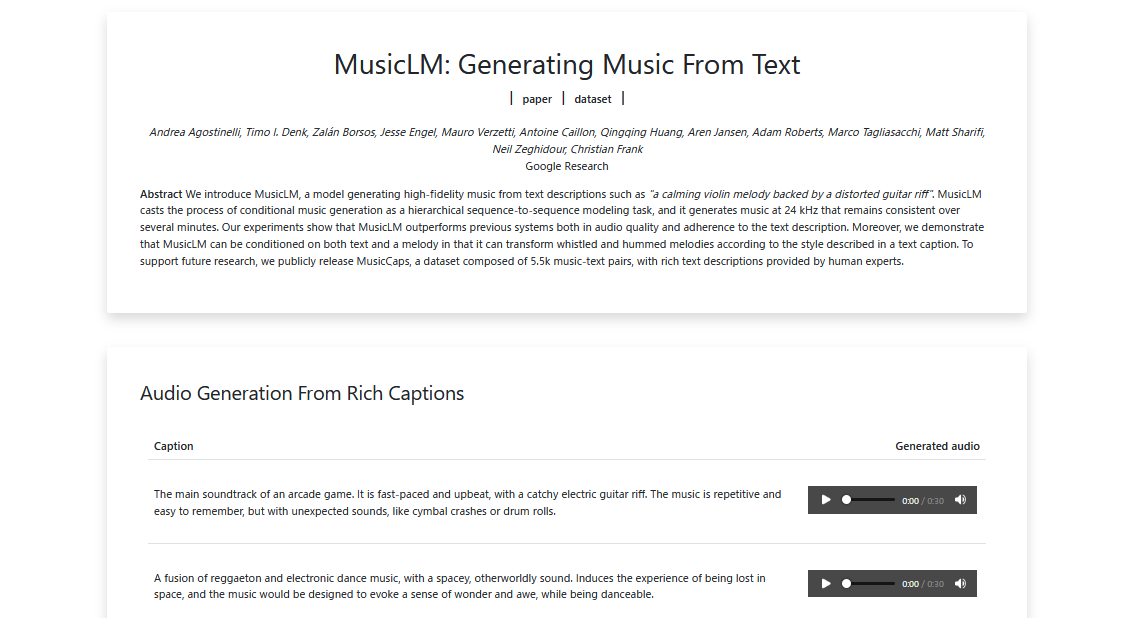

“ChatGPT”はテキストを返して会話を、”StableDiffusion”は画像、そして”Text2Music”は音楽を生成します。このようなTextによる対話的な操作のことをプロンプトエンジニアリングといいます。コンピュータを詳しく扱える人ならコマンドラインの入出力をイメージするとわかりやすいでしょう。

下記の一つ目の例では、アーケードゲーム音楽を作るように指示を出し、それにつづいてどんな曲にするのか説明を加えています。

https://google-research.github.io/seanet/musiclm/examples/

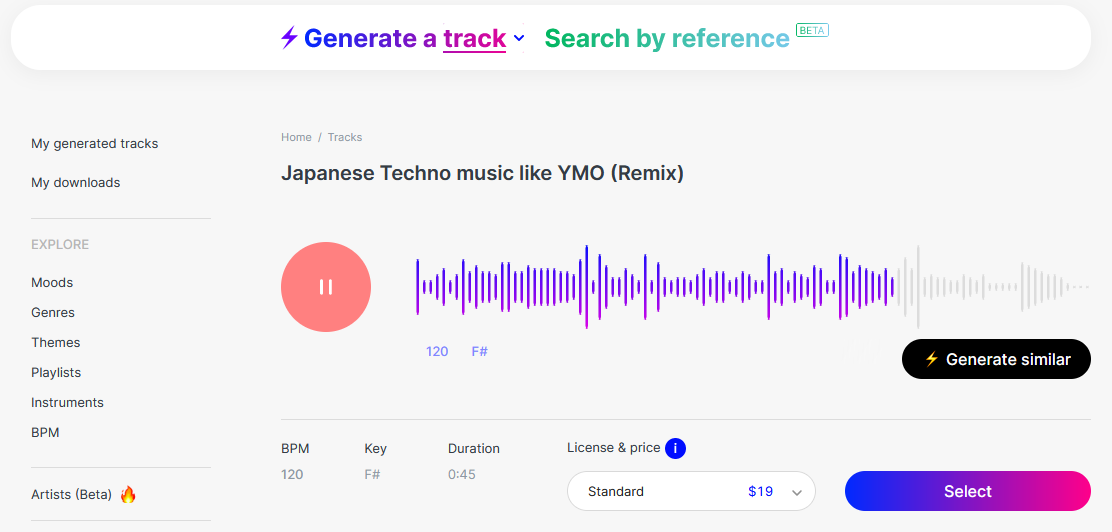

また違うサイトですが”Text2Music”ではmubertのサイトをつかって音楽を生成してみました。

https://mubert.com/render

うーん、ちょっとイメージがちがいますが、一応生成しました。

生成系AIでは、入力された画像や音声などに対して、指示を出すこともできます。たとえば~風の音楽にしてとか、鼻歌から伴奏をつくったりとか、できるようです。そのうち自分の歌や演奏に、リアルタイムに伴奏してくれることも可能になるでしょう。

ここで思うことは、これができたとしてどのような未来を想像したらいいのだろうか、ということです。前回の投稿”IOWN / NTT”、ではリアルタイムで遠隔地と人と演奏する話題でした。また最近の画像処理では、自分と違う人の顔であたかも自分が話をしているように見せることもできます。OpenAIのChatGPTで驚いたことの一つに、文章の構成力でしたが、翻訳の精度にも驚かされました。(音声のテキスト化ではWhisperがあります)これらが簡単に扱えようなの世の中になったとき、人類のコミュニケーションの仕方が劇的に変わると思っています。(音楽によるコミュニケーションはさらに高度なものに。あらゆるチームプレイが高度化)

Text2〇〇でつくられる画像や音楽が、人の創造性を超えるとかアーティストの仕事を奪うとか言われることがありますが、私はそれはないと思っています。それができたしてもそこに面白さがないからです。(面白いことは自分がしたいから)また私の専門分野でもありますが、ローコードやノーコードの流れの中、さらにChatGPTによってプログラマの仕事が少なくなるなどとも言われます。しかし少なくならないといけないのではと思っています。

インターネットが普及する前、「ソフトウェアクライシス」という言葉があったのをご存知でしようか。今後このままでは何十万人のソフトウェアエンジニアが足りなくなる、という危機の話です。当時はそれぞれのソフトハウスで独自に開発をしていたため、ソフトウェアの開発効率も悪く、工数がかかっていました。しかしインターネットが普及してオープンソース開発が当たり前になってくると、そのようなことを聞かなくなりました。オープンソースというのは、プログラムの設計図となるソースコードを公開するということです。当時は企業秘密に近いものがあり公開などとんでもない、といった風潮でした。それが今では公開した方がバグの発見確率も高くなったり、プロダクトに参加する人が増えることから、品質もあがるなどのメリットがあります。なによりも大量のコードを再生産できたことで社会のITインフラを支えことにつながりました。これから先さらにITインフラが高度化、複雑化するにあたり、大量のコードが必要になります。(次のクライシスはAIが解決) ITエンジニアの仕事の種類はどんどん変化しますが、これに携わらなければならない人は減らないと思っています。

ここで一つの教訓があります。未来を予測するときに現在の延長で考えるとよみ誤ります。このままでは~になる、という悲観的な予測が世の中にはあふれています。

ITに関しても労働力人口の減少をAI、ロボットがカバーするという考え方と似ていますが、次の社会課題の解決にAIが不可欠になってきたことが、次第に現れるようになってきた気がします。一番深刻な課題という意味では、環境問題や戦争ですが、前者はテクノロジー、後者はコミュニケーションが解決に寄与すると期待しています。

IOWN / NTT

離れた場所で通信を使った音楽のセッションは、古くから多くの人がさまざまのアイディアを試してきました。

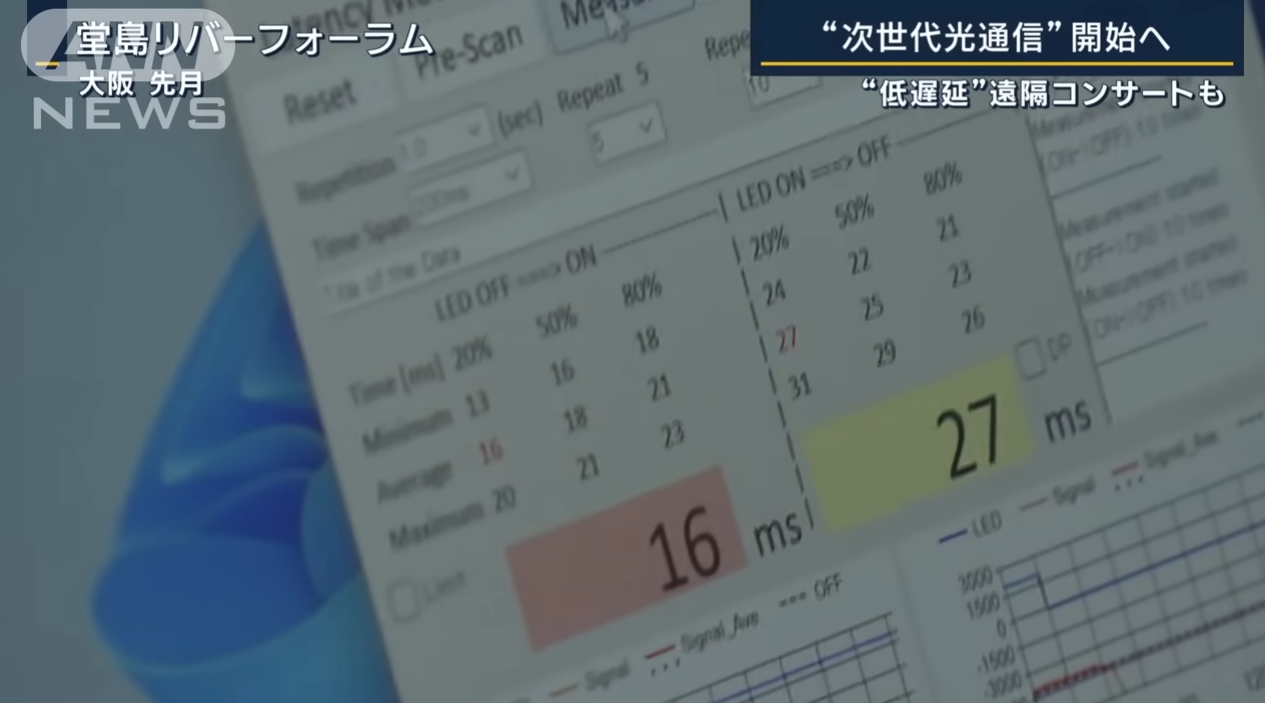

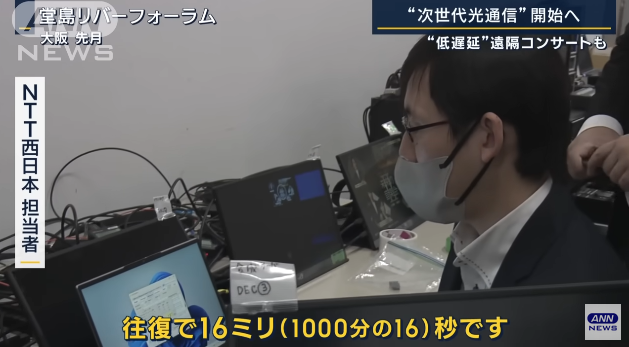

まさに夢の技術とされてきたものが、NTTのIOWN(Innovative Optical and Wireless Network)の低遅延通信により実用段階に入ってきました。(動画では東京大阪間往復16ミリ秒(以下ms)という説明)

これについていろいろと推測しながら考えを整理していきたいと思います。

技術の進歩とともに帯域が広くなったことで送れるデータは多くなりましたが、物理現象として今も昔もケーブルを伝わるデータに遅延があるのは同じです。これ以外の遅延の原因は、データ圧縮・解凍によるバッファや、中継器のバッファ、通信を安定化させるためのマージンとしてのバッファが考えられます。(帯域が広くなることによるデータ圧縮の不要、光によるシンプルな中継器、安定したインフラ、これらによって遅延要素は減少)

時間軸で圧縮するようなエンコーダだと演算に必要なある程度幅のあるデータをバッファリングするため、これは実感できるのですが、中継器やインフラについてはあくまで推測です。

動画だと、実験でどのようなインフラを使ったのかわかりませんが、光ケーブルの専用回線ならかなり安定感はあるはずです。(IOWNのWがWirelessなのでこれは遅延要素だと思いますが・・)

物理現象としての遅延は、相対性理論から、最速でも、真空中における光速の値は 299792458 m/s(約30万 km/s)で、これを下回ることはできません。

東京大阪間は直線距離で400km、新幹線のような経路では500kmとなり、

500/300000 = 0.0001666..

往復で約0.33msとなります。

地球一周だと、40075kmで

40075/300000 = 0.1334833..

約133msとなります。

120BPMで16分音符が125msですが、これより少し長いです。

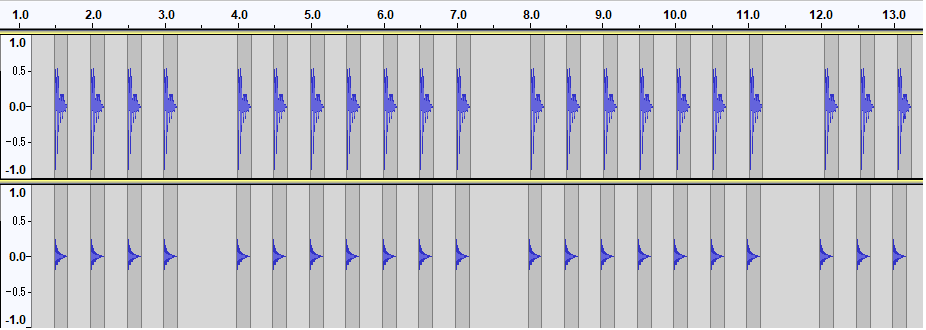

今回16msの遅れということで、波形ソフトで16msずらしたBassDrumとHiHatの音をならしましたが、気にならないレベルでした。

※ジャスト、16ms、30ms、60ms のズレを7回ずつ再生しています。

(どこまで許容できるでしょうか・・楽器によりかなり感じ方が変わりそうです)

さずかにドラムの音の32分音符のズレ(120BPMで62.5ms)は気になりますが、30msくらいまでは問題ないレベルだと思います。

また映像で言えば、60fpsで1フレームが約16msになります。同時の次のフレームには間に合っているということですから全く問題ないです。

ここまで画像や音声のエンコードの時間は入っていませんが、現在のプロセッサで並列処理をしてしまえば極限まで速くできることは想像できます。特に画像は並列処理がしやすいのでいくらでも帯域が許されるかぎり高画質にできるます。

ただ、地球規模では、遅延の少ない演奏は難しいといえます。

しかしモニターするのをエコーバックのみに音声にしてしまえば、133msの遅延は半分になり遅延の気にならない演奏ができそうです。イメージとしてはMIDI音源をながいMIDIケーブルを使って演奏したときの遅れみたいな感じです。聴こえ音が遅れるので演奏する人もそれを計算してはやめに演奏します。このあたりの慣れは脳が補正しています。(ドラムパッドのMIDIアウトでサンプラーを鳴らすときの遅れも同様)

MIDIの転送レートは31.25kbpsでシリアル通信なので、同時に10個の鍵盤を押しても順番に信号が送信されるため同時には届きません。これが帯域が狭いほど遅れる原因になります。帯域と遅延の話は、MIDIに例えるとわかりやすいかもしれません。

31250*(16/1000) = 500

16msで500bitつまり62.5byte。1音につきチャンネル、ノート、ペロシティの3バイトなので、16msで約21 音処理できます。

単純に言えば2人の鍵盤奏者が同時に1つのキーボードを10本の指でノートオンした場合(連弾のイメージ)、最初の音と最後の音では16msずれることになります。

アナログシンセ(CV-Gate)のレスポンスが速く感じるのは、データでなく電圧制御だからでしょう。(ケーブル内を電子が移動するから?押し出す感じ?)

動画で、16msの遅れを3mくらい離れた人に音がとどく時間とありますが、これは厳には音速は15℃で340m/sですので、5.44mになります。

「Sound Lag」

こちらの投稿で音の遅れについて書きましたが、野外での演奏を考えれば、34mで0.1秒くらい平気なので、気にしなくても良いレベルかもしれませんね。

最近はzoomやteamsなどを使ったオンライン会議が盛んになってきたため、リモートで会話する機会が増えました。会話レベルならいいのですが、まだ音を合わせるほどには至っていません。しかし音楽教室などの一方的な演奏であれば、音質などの面で実用レベルにきています。最近GoogleMeet(遅延は比較的少ないと感じている)で打ち合わせのような音合わせをしましたが、コミュニケーションが問題なくできるレベルでした。PCよりもスマホとそのアプリの方がカメラ・マイク、通信デバイスのバランスが良い(と私は思っている)ため遅延が少ないと感じました。ちなみに遅延は往復で500msくらいでした。

テンポの遅い曲で、ピアノ伴奏+弦楽器だったら、100msくらいでもできる気がしますので、もう一息といった感じでしょうか。。

いずれにしろ、遠隔での演奏がどんどん当たり前になってくると、また新たな音楽の楽しみが増えることは間違いなさそうです。

Yukihiro Takahashi / YMO

高橋幸宏氏の訃報から、ネットでYMOの曲を再びよく聴くようになり、昔の記憶が芋づる式によみがえる今日この頃です。

ブログを書くつもりはなかったのですが(やすやすと書けない)、下記の追悼特集を見ていて、何か書きたくなってしまいました。たぶんまともな投稿などかけないので、このタイミングで少しでも記録を残す意味で簡単にまとめてみました。

「Daisy Holiday! 細野晴臣<手作りデイジー>高橋幸宏さん追悼特集 2023.1.22」

https://www.youtube.com/watch?v=i8GOOZdSj_I

「山下達郎のサンデー・ソングブック 極私的・高橋幸宏さん追悼特集 2023.1 .29」

https://www.youtube.com/watch?v=RIvfTpBXPrQ

※上記YouTubeサイトに移動しないと見られません(iframeではNG)

細野さん、教授、ユキヒロ氏と呼ばせていただきますが、この三人そして魅力的なサポートメンバーの才能から生み出された楽曲から、私の音楽人生は多大な影響を受けました。音楽面だけでなくその背景や彼らの接点などからも多く学びました。

ドラマーとしてユキヒロ氏はとにかくフレーズがかっこよく、それが楽曲の一部としてなくてはならない存在感があります。奏法的には、スティックやビーターを打面に押さえつけて叩くタイトな音が特徴的ですが、これは真似できないです。YMO後期にシモンズのエレクトリックドラムを使いだしたとき、これが本来のYMOの音だと、その楽曲のはまり具合に、魅力が倍増したことを思い出しました。シーケンサやパーカッションエフェクトは使っていたものの、初期のYMOはほとんど生演奏で、人力テクノといわれるほどでした。ここから三人のミュージシャンとしての技量の高さがうかがえます。

細野さん、教授の才能がユキヒロ氏のフィルタを通ることによって、ポップになり商業的な成功を収めたという見方もありますが、私もそう思います。ドラム、作曲、歌、ファッションと多才で、本当のアーティストと呼べるのはこういう人のことでしょう。

これ以上、どう書いていいのかわからないので、私のお気に入りの曲を二つ紹介して終わりにします。好きな曲ばかりで選ぶのは難しいのですが、やはりドラムがかっこいいものにしました。

カムフラージュはサンプリングパーカッション、邂逅はオーバーダブしているシモンズが秀逸です。

(YouTube検索でヒットしたものです)

「カムフラージュ/BGM」

「Yellow Magic Orchestra Winter Live 1981 – 4 Camouflage」

「邂逅/浮気なぼくら」

「邂逅 – YMO」

夢中にしてくれた幸せの時間、本当にありがとうございました。

3月5日追記

(練習不足でスミマセン、パターンの繰り返しがきつい。。40年以上前の楽曲とは思えない新しさ。ライブでは演奏されていない曲だが、どうやった叩こうかと思わせる曲。)

4月8日追記

2023 MY EVENTS

今年は演奏する機会が増えそうです。

3月にはコロナ禍などで中断していたバンド活動を4年ぶりに再開し、そのライブがあります。

熱帯JAZZ楽団「MACHETE」のドラムを叩く予定なのでV-Drumsで演奏してみました。(↓動画 なせか音声がまたモノラルになっている・・)

V-Drumsを購入してもうすぐ2年くらいになりますが、これのおかげで練習が楽しくなりました。長らくドラムをやっていますが、アコースティックのドラムセット(生ドラム)を叩いて練習できた時間は数パーセントに満たないくらいです。これまでの多くの時間は練習パッドがメインでした。そう考えると、いろいろな楽器を習ってきましたが、生ドラムは練習の方法についてちょっと特殊な楽器になるかもしれません。

バンド以外にも、バイオリンとジャズベース(コントラバス)の発表会があります。

いろいろな楽器をやっているという実感はなく、演奏したい曲を見つけた後演奏する楽器が決まるという感じです。楽曲と格闘しながら修得していくプロセスに楽しみを感じることを最近気づきました。

発表会演奏曲

2023 ContraBass チャーリー・パーカー「コンファメーション」

2023 Violin シークレット・ガーデン「Song From a Secret Garden」

2022 Cello 坂本龍一「1919」

2021 Violin アストル・ピアソラ「リベルタンゴ」

2020 Cello ジョン・ウィリアムズ「シンドラーのリスト」

2019 Violin 葉加瀬太郎「情熱大陸」

2018 Cello フレデリック・ショパン「別れの曲」

その他余興

2022 Violin MISIA「アイノカタチ」

2021 Cello ケルティック・ウーマン「You Raise Me Up」

弦楽器の練習するときに感じるのは、音量が控えめなので自宅で練習しやすいのと、ピッチ合わせが難しく、デリケートなので、一音一音に集中力がかなり必要になります。そのため頭の中から雑念が消えるというか、他事を忘れることができるためとてもリフレッシュできます。一時期は打ち込みの音楽しか聴かない時期がありましたが、生身の人間が毎回違う演奏することが面白いと思うようになり、それ以来演奏を楽しんています。ドラムはスポーツ感覚というかダンスに近いものがあり、元気がでますね。

新しい年のはじめに元気に叩いてみました。

それから余談ですが、音楽以外にも興味があることが増えています。最近よく思うのですが、人類史上経験のない膨大な情報に一般ピーポーがアクセスできる時代ということです。YouTube一つとってもエンターテインメントから教育、趣味に関することなどさまざまな情報が無限にあり、人々の好奇心を刺激しつづけています。

これまで高度な教育を受けていないと得られなかったり、高い書籍や授業料が必要だったコンテンツが無料動画でしかも検索して即入手できることは驚異的です。(難解な理論も動画での説明がわかりやすいので理解が進みます)

このような状況に、年齢とともに体力面では衰えはあるかもしれませんが、脳は成長しつづけている感じがします。80代でプログラムを学びはじめiPhoneアプリ開発者である若宮さんが少し前に話題となりましたが、年齢とともに衰えると考えるのは、間違いですね。逆にこれまでの経験が増幅されるためよりパワフルになれます。さらに進んでメタバースでアバターを使うことがさかんになれば、国籍も年齢も性別も関係なくコミュニケーションできます。今でもテレワークによるオンライン会議をしているとこのような未来がすぐそこまで来ていることを感じます。

今年は、これまで3Dグラフィクス、AI、ロボット、そして昨年のブロックチェーンにつづき量子コンピュータの記事もブログに書いていきたいと思っています。

https://decode.red/

(音楽に関してはドラム奏法の拡張性がテーマ)

Negative Harmony

Jacob CollierがYouTubeで広めて有名になった音楽理論(オリジナルは古い)で、私も調べてみました。

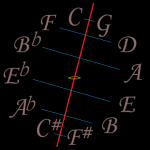

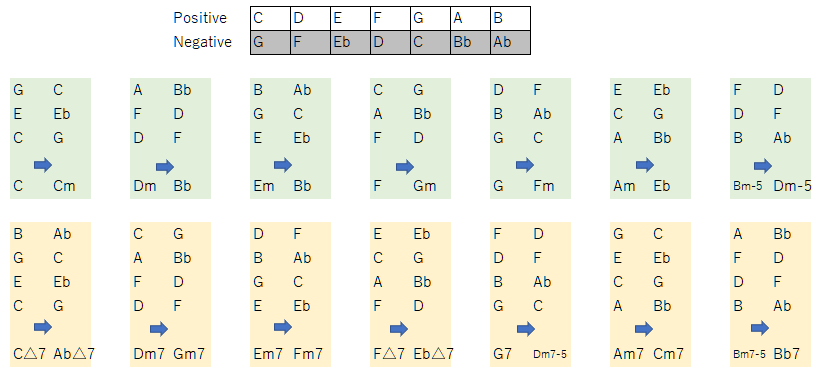

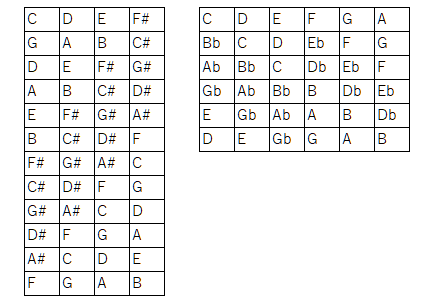

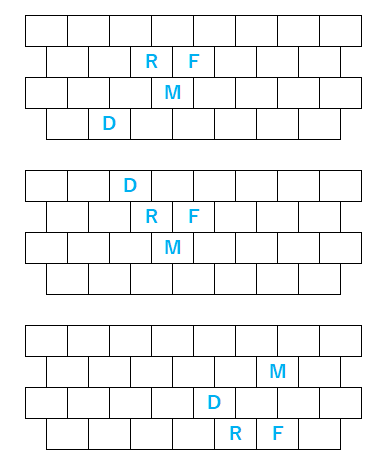

5度圏を左右に割ってそれぞれの音を交換可とするものです。

ネガティブということはポジティブに対するものであり、この交換により明るいメジャースケールはマイナースケールに変換されます。

ちょうど陰と陽、夜と昼、月と太陽のような関係に似ているでしょう。この話題にタイミングよく今週11月8日は、442年ぶりとなる皆既月食+天王星食が見られました。

このような天体ショーは、天がときどき人類が宇宙の一部であることを教えるがごとく巡ってきます。きなくさい世界情勢の中、ちっぽけな自分たちの存在を謙虚にうけとめたいものです。

私も観測にいき天体望遠鏡のファインダーからですがiPhoneのレンズをくっつけて、思ったよりきれいに写真をとることができました。今回天気も良く長時間にわたって観測できたため、長く楽しむことができたのではないでしょうか。

他の惑星も見ることができ、土星の環、木星は衛星までも観測できました。

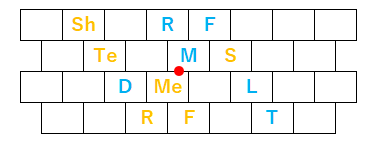

話が脱線しましたが、ネガティブハーモニーの仕組みを図示しました。

このように書くと、一見同主音単調の借用和音のようにも見えますが(モードチェンジしただけ?)、C-G, D-Fの変換が面白いと思いました。

また下記動画でJacob本人のインタビューをもとにしたわかりやすい解説があります。

ここに出てきたスーパーリディアンなるものの説明にも興味を持ちました。

リディアンスケールを左図のようなルールでつなげていくもの(5度圏の#側(陽))と、ミクソリディアンスケールを右図のようなルールでつなげていくもの(5度圏のb側(陰))で、オクターブをまたいで変化していく様子が興味深いです。

ネガティブハーモニーのケーデンスは、V-I から IV-I 変化しますが、このとき

Fm7 -> Bb7 -> Cmaj7

というバックドアケーデンスというものが現れます。動画でもこの用語が使われていますが、初めて知りました。

フロントドアもあるのか、ということで調べてみると、

Bm7-5 -> E7 -> Cmaj7

とありましたが、ネーミングは定かではなさそうです。

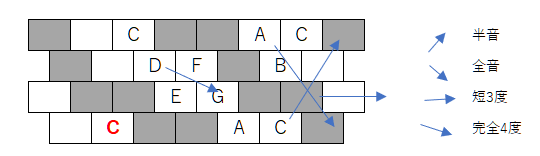

このような周期的な音列を演奏するとき、どんどん転調するためピアノのような鍵盤楽器ではなかなか困難なので、これもタイミングよく最近マイブームである転調しても同じ運指が使えるクロマティックキーボードを使える環境を整えてみました。

下記プログラムを改造して、PCキーボードのクロマティックキーに見立てたコードをMIDI出力できるようにしました。

https://decode.red/net/archives/1040

もともとボタン式クロマティックアコーディオンに興味があり、いろいろと調べていたのですが、高価であるためなかなか手がでずにいました。しかしキーボードだけは体験してみたいと思いPCキーボードを使ってクロマティック演奏を試みました。配列はB-SystemとC-Systemがあるようですが(上下が逆)、C-Systemの方がよく使われているときいたことと、RolandのV-Accordionが採用しているということで、こちらにしました。

実物とは程遠いですが、思った通りこの配列を使うとこれまでと違った感覚を味わえます。(和音の形が視覚的にわかる)

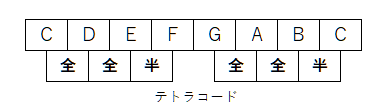

せっかくなので現在勉強中のまとめとして、3タイプの指の形を図示します。音階をひくときにテトラコードを意識すると、横スライドするとき、縦移動で上下にキーが切れたときにフレーズをつなげやすいのかと思っています。

ネガティブハーモニーの話題に戻って考えると、横方向の移動は短3度なので、C->Eb つまり C->Cm となり転調がしやすく親和性が高いです。(Cの1つ左からスタートするAマイナーのスケールをそのままの形で右に1つシフトします。”Chromatic Keyboard”動画の最初の部分)

また交換する音は点対象(天体ショー?)として表せます。

音楽はいろいろな見方ができるから面白いですね、

ネガティブハーモニーを知ったときに思ったのは、光の色を周波数で見る見方と三原色で見る見方の違いに似ているような気がしました。

また整数比から音階を発明したピタゴラスが、宇宙と音楽はともに調和(ハーモニー)がとれて奏でているとし「天球の音楽」といったことを思い返しました。

恵まれた天気で皆既月食を観測できたのも、世界に調和を、という天の声かもしれません。

いろいろな話が盛り沢山になってしまいましたが、このブログらしい展開に自己満足しています。(^^)

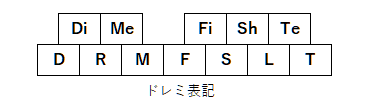

※ドレミ表記のもともとのアイディアは以下

iPhone Apps

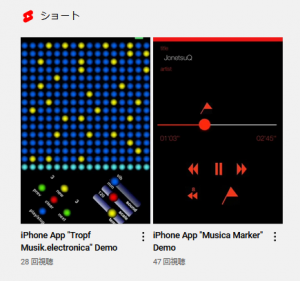

7月にApple Developer Program に復帰してから、過去のiPhoneアプリを2つ(MusicaMarkerは6年ぶり, TropfMusikは12年ぶり)アップデートしました。

iPhoneアプリの開発は発売当時からやっていますが、途中中断をはさんで3度目の開始となります。

“MusicaMarker”は、ライブラリにある曲の任意の場所をワンタッチ呼び出しができるアプリで、曲を繰り返し聴く必要がある楽器練習のときや、語学の勉強に便利です。”TropfMusik”はこのBlogの最初の方でも紹介しました、Matrix Sequencerです。

ふりかえってみると、開発のきっかけとなったのは、最初にアメリカで発売されたときちょうど仕事で在住していて、同僚が持ってたものを見せてもらったり、いきなりJailBreakのやり方を教えてもらったりして興味を持ったことからです。この頃、SONYのPalmOSやSHARPのLinux Saurusのようなモバイル端末の開発もやっていましたが、その違いに衝撃を受けました。

印象的だったのは、今となっては当たり前ですが、写真のピンチイン/アウトやローテート、なめらかな動き(とくに慣性をシミュレートしたスクロール)をするI/Fです。Apple製品は本当に時代を先取りしているのを感じます。Macが発売されたときもそうでしたが、フロッピーディスクが自動イジェクトするなど、未来のコンピュータという感じでワクワクしました。

帰国してから日本でも発売され、開発を初め、6年前までで、20タイトル以上をリリースしました。売れる売れないに関係なく音楽をテーマにしたアプリで自分が欲しいというのも作って楽しんでいました。ちょうどこのブログもそういった気持ちでやっているのと同じです。(YouTube動画のアップロードももともとiPhoneアプリデモを見せるのがきっかけ。だからipsound。そういう意味では初心に戻ったことに。)

iPadが発売されたときは、グランドオープンと同時にアプリリリースしました。

しかしその後ユーザサポートや、バージョンアップにともなう開発機材のコストが負担になることもあって中断しましたが、Swift言語の登場とこれを使った案件をいただいたことをきっかけに一時再開しました。その後縁がなかったのですが、Apple Siliconへの歴史的転換やAR,AIの機能をみて、参入のタイミングをはかっていましたが、ようやく最近環境が整い再々開しました。

Developer Program に復帰してから、AppleStoreには、過去のアプリを出現するようになってしまいましたが、動作しないもの、強制的に削除されたものがあり、混乱状態にあります。

基本的に最近アップデートし動作確認したのは、いまのところ下記2タイトルだけです。(“Perfect Pitch Practice Piano”は動作確認済)

https://apps.apple.com/app/id1082130243

https://apps.apple.com/app/id369685150

Demo動画(short movie はembededできない?)

https://youtube.com/shorts/1OaWi2Ijpd0

https://youtube.com/shorts/Hjk6riZAbQg

CPUが32bit(iPhone5まで)から64bitに変更されたことにより、特に私のサウンド関連のアプリは大幅な変更をする必要がありました。今後数タイトルを復帰させ、それから新規のアプリも作っていきたいと思っています。(2016年のSwift言語で開発したアプリはiPhoneによっては動作するかもしれません)

過去アプリの情報は、

http://iphone-old.iiv.jp

まだ移行中で一時的なWebサイトは、

http://iphone.iiv.jp

です。

Breath of Groove

今回もドラムマガジンの誌上ドラム・コンテストにチャレンジしました。

https://drumsmagazine.jp/special/contest2022/

春は「SUPER INSPIRATION」という32小節の小曲でしたが、夏はいつもどおりです。前回(春)のときテンポを倍にしたアプローチがカッコよかったので、今回まねしてみました。

歌ものということでBreath(息、呼吸)という言葉が使われたと思いますが、息継ぎができないくらいハードなプレイとなってしまいました。(笑)

反省) 動画の音声のLチャンネルが無音になってしまった。(接触不良? iPhoneのスピーカで聴いてアップロードしたのでわからなかった。 どうしよう・・)

あと、Rolandの100人セッションの曲の動画がとても楽しそうだったので、叩いてみました。

https://blog.roland.jp/event/playerssummit2022_100ss/

反省) ハイハットが回ってしまい、センサがない部分になると音がならない・・

結局、前のブログと合わせて本日だけで3つの動画を収録することとなりました。(まるでミッションをこなすかのごとく) ドラム三昧の一日に、ちょっと息ぎれ。

Ryū kyū Scale

琉球音階は、ド・ミ・ファ・ソ・シ からなる5音音階で、たっだ5音を奏でただけで琉球の音楽とわかる強力なアイデンティティを持っています。

テンポが速い曲も遅い曲も底抜けに明るい印象があります。

今回このスケールをガイドにドラムを叩いてみました。

反省) 動画の最後のURLが間違っている。jpがjoに・・orz、次になにやるか迷い手がおおい。

きっかけとなったのは先月TBSで放送された「音楽の日」にモンゴル800が演奏した「琉球愛歌」を聴いたことでした。「小さな恋のうた」はカラオケで歌ったことがあり知っていたのですが、この曲は初めて聴いて、そのリズムの多彩さに圧倒されました。歌詞とメロディとリズム全てで訴えかける、すごいパワーを感じました。いろんな音楽がありますが、その人の人生とか感情とか音楽で伝わるものなのだと実感しました。この曲の歌詞は今の時代考えさせられます。歌詞つきのいい動画がありましたので、貼り付けました。

モンゴル800の曲は他の曲もそうなのですが、リズムのテンポが倍になったり半分になったり、間が独特だったりと、曲がドラマチックに展開します。人もそれぞれ違うリズムを持っていますが、どんなリズムも受け入れる寛容さ、スケールの大きさを感じました。

Sound Lag

野外などの広い場所で楽器を演奏していると音ズレが気になることがよくあります。それは音が進む速度(音速)が意外と遅いからです。

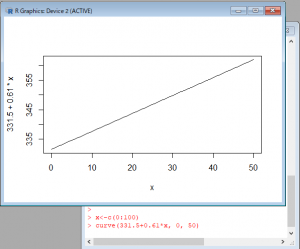

気温に影響を受けるため、その関係をRの関数でグラフにしてみました。

参考)WiKiPedia

https://ja.wikipedia.org/wiki/%E9%9F%B3%E9%80%9F

一般的に15℃で秒速340mとしているようです。

340mというと34mで0.1秒ずれることになり、マーチングバンドの演技フロアが30m x 30m ということを考えるとその影響は大きいです。(120BPMで16分音符が0.125秒)大編成のパレードなどではさらに大きなずれが生じます。

ずれないようにするため、指揮者を複数人置いたり、練習ではメトロノームを複数台使ったりするようです。(フロアなら有線のスピーカ、野外だとFMトランスミッタで送信して携帯ラジオで受信など、試したことがあります)

過去にiPhoneアプリで同期メトロノームを販売したこともありました。

(12年前の懐かしの動画です。こういうのを残してくれているとこがYouTubeのいいところですね)

また音ズレに関して言えば、ネットを使ったセッションでもいえます。音声のエンコード・デコード、データ送受信のバッファリングのしくみを考えれば、かならずレイテンシーは存在します。ところが人間の能力でそれをある程度カバーすることが可能であることを、ユーチューバのかてぃん氏の動画で見たことがあります。自分の演奏(のフィードバック)が少し遅れて聴こえることを許容すると、遅延を半分にできるということです。

簡単に言えば遅れることを前提にセッションするということでしょうか。

他にも音ズレというのは、勘違いを引き起こすことがあります。

今月はじめ参議院選挙期間中に安倍元首相が凶弾に倒れました。許しがたい犯罪で社会全体が暗い気持ちになりました。こういうとき社会が冷静になるためには正しい情報を知る努力をする必要があると思っています。銃撃されたシーンの動画がネットに上がっていますが、その一つが2度目の銃撃の前に襟元が動くことから、容疑者以外が狙撃したという指摘がされています。その動画(動画A)には容疑者が映っていないため、発射のタイミングが特定できないことと、煙のタイミングより後に発砲音がなっていることから、容疑者が映っている別の動画(動画B)と重ねて見てみました。動画Bは襟元が識別できませんので、iMovieで動画Aのピクチャーインピクチャーで見た目を合わせ同じタイミングで同時に再生されるようにしました。すると動画Aの音声トラックが0.2秒ほど遅れており、襟元の動きは容疑者の銃撃によるもののように見えます。

しかし動画Aには襟元の動きと同時になっているヒュンという鞭が空を切るような音が入っているのですが、これが狙撃の音だという指摘があります。(動画Bでいえばさらに0.2秒前になる)

この空を切る音と2度目の銃撃音の間には0.28秒ほどの時間差があります。銃弾は音速を超えるので、爆発音より早く聞こえるのは問題ないような気がしますが、0.28は長すぎるように感じました。気温を30とすると音速350m/sくらいで 350 x 0.28 = 98mです。98m離れていないとこの時間差を感じられない、ということになるからです。(そうするとこの音は容疑者の銃撃とは無関係ということになります)

そもそも弾丸の飛ぶ音かどうか、音速を超えたときのソニックブーム(衝撃波)が聞こえるタイミングだとか、弾丸の正確なスピードだとか、こういうに詳しくないとだめですね。

前々回の選挙のこともそうですが、タイトルからは飛躍した内容になってしまいました。そういえば以前もSoundCloudの話題で、ショパンコンクールの話題を取り上げたりしましたから、こういうBlogだと思えばいいのか、と開き直りました。

なにより発信、OUTPUTが大事と思っています。

昔の動画はまだユーチューバーという言葉がない時代、容量の大きい動画ファイルの置き場程度のことでYouTubeを使っていましたが、今は随分とその役割がかわったことを改めて思いました。

iPhoneアプリまた作りたくなってきた・・

D5 Creation

D5 Creation